《波士顿现场直击》

创立超过30年的老牌操作系统商红帽,在今年年度大会中,披露了新的GenAI发展策略。

突然爆红的生成式AI浪潮和发展多年的IT现代化浪潮,带给企业两个不同的课题,红帽首席执行官Matt Hicks指出,一个“当前”的世界,另一个是“未来”的世界,现在的世界是混合云、虚拟化、现代化、安全性的混合挑战,但未来的世界完全聚焦AI,大规模运行的AI是企业新的挑战。

红帽过去的产品发展策略,一向聚焦企业当前的挑战,Matt Hicks解释,红帽专注于企业真正运行的环境,也就是让任何工作负载、任何应用程序,都可以在公共云、边缘上执行,让企业可以处理传统应用程序、虚拟化工作,也能安全、大规模地执行各种眼前的业务。

过去两年来,公有云巨头和AI领导企业,如OpenAI、微软、Google、Nvidia、AWS等,善用手上的庞大算力和海量数据,来发展出各式各样的大型语言模型或可落地部署的小语言模型。

但是,对红帽这家成立三十多年的老牌软件商而言,他们的策略坚持不走大型语言模型研发路线,而是要想办法善用原本的优势,来卡位新一波的代理AI浪潮。

红帽首席执行官Matt Hicks表示,红帽产品战略转向任何模型、任何加速芯片、任何云的支持。图片来源/红帽

为了支持企业大规模的运用GAI,红帽在年度大会第一天开场演讲中,宣布了五项重要的产品战略。

第一项宣布是“新AI战略方向”。Matt Hicks比较,过去的战略是通吃任何工作负载,任何形式App,可以在任何地方执行(Any Workload,Any App,Anywhere),随着生成式AI全球爆红之后,带来了全新的工作负载形态,所以,红帽新的GAI产品战略也转向到瞄准“任何模型、任何加速芯片、任何云(Any Model、Any accelerator、Any Cloud)”的支持。

这句话的意思是,红帽未来的产品发展,要能够支持企业可以运用任何类型的模型,在不同品牌的加速芯片上,或是任何模式的云计算环境,从公有云,私云到地端边缘运算环境的生成式AI工作负载,红帽未来都想要支持。

今年年会的第二项重要宣布是,红帽推出新版开源操作系统RHEL(Red Hat Enterprise Linux) 10。

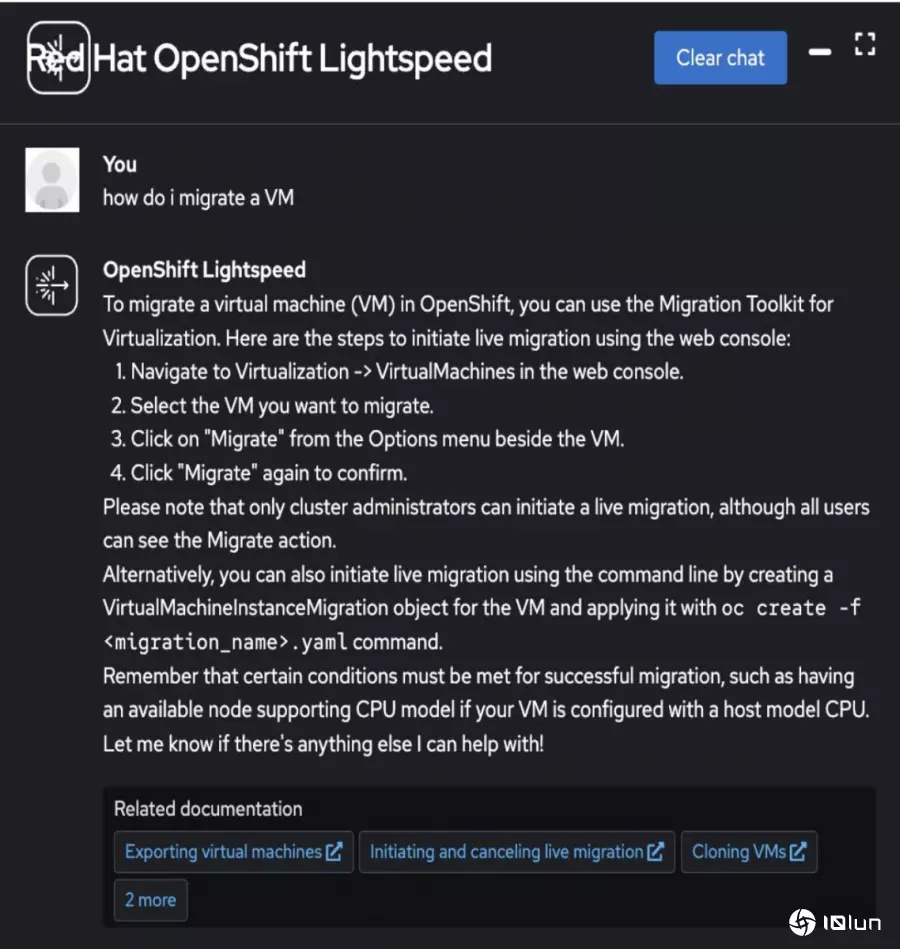

红帽首席产品官Ashesh Badani更强调,这是20年来最强大的新版本,可以通吃混合云和AI工作运算需求,其中一项重要的新功能是可以大幅简化运维的Image模式,让OS更新就像手机更新一样简单,Image模式可以让运维人员改用容器镜像文件的部署更新方式,取代传统的套装组件安装方式,将容器化应用的管理体验带到底层操作系统的组件管理上。另外,RHEL 10也推出了命令行的Linux通用AI助理Lightspeed服务,可以协助解决各种操作系统运维和使用的问题建议。RHEL也是第一款提供NIST批准的后量子加密算法的商用操作系统,为日后的量子破解风险和相关合规要求,预作准备。

红帽也将生成式AI带来操作系统管理和基础架构管理,推出了LightSpeed运维助手,不只在新版RHEL 10中,也能在虚拟化平台和OpenShift中提供运维建议。未来计划推出本地部署的版本。图片来源/红帽

第三项产品宣布是以vLLM为基础,推出全新的AI推论服务器。红帽去年11月并购了vLLM项目主要贡献者Neural Magic,纳入Red Hat AI团队。红帽首席技术官Chris Wright强调,在AI世界,企业想要的生产上线( Production ),如何支持企业大规模的GAI使用是焦点。

这个可以用来加速LLM的开源项目vLLM,超过50万次下载,可以将模型推论的吞吐量提高数倍。红帽也以Neural Magic的技术为基础,推出vLLM的AI Inference Server (红帽AI推论服务器),可以支持各种模型,也能部署到各种环云计算环境中。

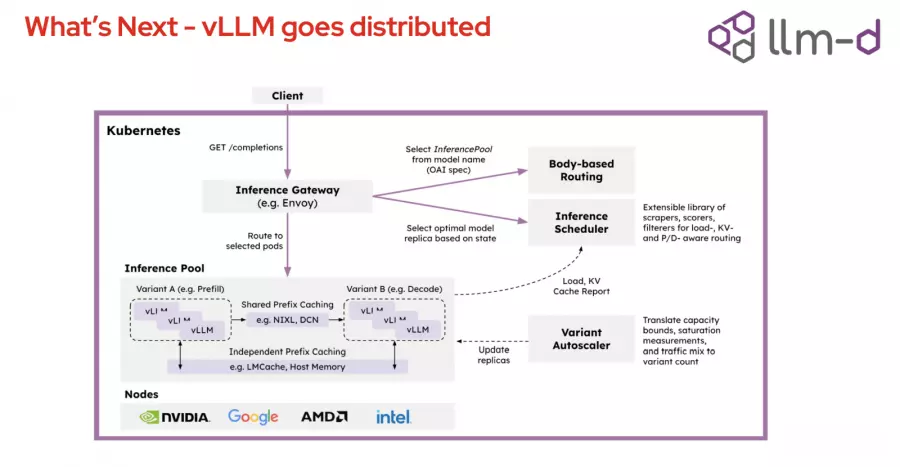

为了打破vLLM技术目前只能跑在单一服务器上的限制,红帽的第四项发布则是推出了一个大规模AI推论加速的开源项目llm-d。Chris Wright解释,llm-d项目以K8s为基础,打造出一个分布式推理架构,可以打破vLLM的单一服务器限制,在正式环境中打造大规模的分布式推理架构,提供十倍推理吞吐量的能力。他比喻,llm-d项目对LLM推论世界的意义,就像是K8s,可以支持超大规模的架构。这项项目的创始成员包括了AMD、Cisco、CoreWeave、Google、Hugging Face、IBM Research、Intel、Lambda、Mistral AI和Nvidia。

不只推出vLLM的新产品,红帽也发布新的开源项目llm-d,要将K8s分布式架构,带来GenAI推论处理。红帽也与许多重要GenAI技术巨头联手开发。图片来源/红帽

最后一项重点是瞄准代理AI普及和大规模部署需求,红帽旗下两大AI产品线RedHat AI和OpenShift AI,未来将支持Meta的Llama Stack框架和Anthropic的Model Context Protocol (MCP) 协议。 Llama Stack提供一整套标准化的GAI构建模块,后者则可以集成到庞大的MCP服务器生态圈。

战略布局1:用容器管理体验,统一基础架构生命周期管理

除了这五大新产品策略外,红帽年会中特别强调今年初展开的虚拟化新产品线布局。红帽在今年年初发布了新的虚拟化解决方案OpenShift Virtualization Engine,这是以OpenShift平台为基础所打造的全新虚拟化专用版本。

原本的OpenShift平台中,集成了容器管理与虚拟化功能,可供企业在单一环境中同时管理容器化工作负载与虚拟机的应用场景。

但是,今年初推出的OpenShift Virtualization Engine专门锁定企业虚拟化的需求,使用企业级验证的KVM(Kernel-based Virtual Machine)技术为基础,移除了与虚拟机无关的功能,像是去除容器管理功能,提供了一个轻量级的选择,专注于虚拟机的部署、管理和扩展调度。

OpenShift Virtualization Engine不仅可以在本地数据中心环境中执行,也能部署到云计算裸机执行实例上,来提供混合云架构的部署弹性。这款产品也内置一套虚拟化平台搬迁专用工具Migration Toolkit for Virtualization,来解决虚拟机搬迁痛点,尽量缩短停机时间。此外,这个引擎还能与Ansible Automation Platform集成,来提供虚拟机的自动化迁移与管理。

长期发展上,红帽希望OpenShift Virtualization Engine能做到跨集群即时转移虚拟机(Live migration)(目前技术预览版),提供更多转移助手工具。未来也希望提供支持多集群架构的可观察性能力但大规模虚拟机的管理能力。针对安全管控,未来也计划让多集群的虚拟机可以提供更精细的角色权限管控 (目前技术预览版) ,也将持续强化多集群运维生命周期的管理,像是虚拟机和命名空间规模适当大小调整功能准备进入技术预览版。

这套虚拟化引擎也将内置到新版OpenShift 4.19中(目前技术预览版),提供预先配置设置,和代理型安装程序,提供引导式的安装流程,让运维人员不用手动撰写YAML或CLI指令。

为何红帽今年反而特别聚焦企业虚拟化需求?红帽的企业顾客区分为四大类,政府公布门,电信,金融,制造服务和零售。其中金融业是最有战略意义的指标产业,因为金融企业往往是新技术的早期采用者,比其他产业更快尝试云原生物科技术和容器技术。

但是,在过去2年,企业虚拟化部署的成本有很大的变化,原本可购买永久授权的vSphere,现在转为订阅制,也让企业虚拟化技术的成本大增,不少企业不只是寻求原有虚拟化产品的替代技术,也更积极转换到容器和云原生物科技术等现代化的技术架构。

红帽也看上这个机会,大力发展虚拟化产品线,一方面接手更多传统应用软件的工作负载需求,另一方面,也要抢攻不同类型产业越来越多的新兴IT现代化需求。先满足这一类传统工作负载需求的企业,等到这些企业日后想要转型或升级到云原生物科技术,可以直接衔接到红帽的OpenShift平台上,为日后的获客先打基础。

推出独立虚拟化平台产品,补齐数据中心管理软件层

在软件架构底层操作系统,和云原生混合云管理软件之间,红帽这个的虚拟化引擎产品,补齐了中间的数据中心软件平台层,可以用来强化网络、存储、数据保护、安全强化、端点到云计算等虚拟化工作负载的管理,也能衔接到红帽OpenShift平台的混合云管理架构,支持四大主要公有云的环境,包括AWS,Google Cloud、Azure和Oracle Cloud。红帽还特别强调,连AWS在台湾的新云计算区域中心也将可以支持。

甚至不只x86架构环境,OpenShift Virtualization未来还能在大型主机系统IBM Z和IBM LinuxONE上运行(目前是技术预览版)。

不只是大型主机,红帽也要将这款产品延伸到边缘设备的支持,已经发布了支持ARM架构64位元处理器(AARCH64)等低功耗环境的开发者预览版本。红帽希望未来可以做到,用单一平台来也能管理到大型主机环境,甚至是边缘设备上的虚拟机,甚至红帽更大的企图是希望未来能做到跨这些不同处理器架构的环境中,提供虚拟机的即时迁移能力。

以OpenShift简化而成的OpenShift Virtualization,同样也延续了原本OpenShift平台的同一套容器化管理做法和体验,可以来管理虚拟机。

统一基础架构生命周期管理体验的最后一里

红帽想要统一基础架构生命周期管理体验的策略,只剩下最后一里路,也就是如何将容器化管理体验,带到操作系统层的运维管理。这正是红帽RHEL 10新功能Image模式所要解决的最后一里管理课题,将容器的镜像文件管理模式,带到操作系统层。

Image模式可以用容器管理体验,包括了用容器配置文件,将容器镜像文件,搭配容器注册服务,将操作系统部署到各种执行环境,从裸机、私云、公有云,甚至是边缘设备的部署管理都可以统一。

传统的操作系统组件部署方式采组件模式(Package mode),通过Image Builder创建镜像文件(虚拟化镜像文件),修补更新时则通过dnf搭配rpm存储库(repository)来发布更新,RHEL新推出的镜像文件模式(Image Mode),则改用容器工具来创建镜像文件(容器化镜像文件),改用bootc容器部署工具和容器注册服务(registry)来发布更新,新的镜像文件模式也可以使用原本组件模式所运用的管理工具,如Satellite和Ansible来创建自动化管理流程。

未来,红帽希望镜像文件模式可以支持镜像文件封装机制,提供更严谨的镜像文件完整性和开机流程,也能支持到最快只要10秒的软开功能力,来缩短宕机重开的时间。

从操作系统,虚拟化平台到混合云管理平台,全都用同一套容器管理体验,可以在任何公有云上,提供虚拟机和容器的统一管理体验,企业也可以在任意平台上执行容器化应用。这是正是红帽今年开始全力发展的第一项战略布局,也正是红帽首席执行官新战略“Any Model、Any accelerator、Any Cloud”的第三项Any Cloud布局,有了这个基础,就可以在上面发展前面两项应对GenAI浪潮的新目标,红帽选择的产品策略切入点就是,瞄准企业未来大规模GenAI推论部署需求。

战略布局2:K8s分散架构带来GAI推论,瞄准大规模推论需求

拥有深厚操作系统背景的红帽,对硬件支持非常熟悉,也和云计算供应商、硬件芯片供应商有很好的合作伙伴关系。红帽首席技术官Chris Wright用一句话点出红帽的新战略定位:“将底层硬件和热门模型的软件架构串联起来,是红帽在整个GAI世界中的位置。”

红帽在年会中发布了,以推论AI加速开源项目vLLM为基础,所打造的红帽AI推论服务器。这套产品架构的上层是各种模型,提供了红帽与不同模型供应商合作的验证模型和优化版配置。

红帽AI推论服务器,不只是一款社交媒体可用版本,而是可以用于关键任务的运行环境。这款服务器也可以说是一套操作系统,核心是Linux,可以用来构建和执行不同的模型。红帽AI推论服务器是红帽AI产品组合的成员之一,可以部署成一台独立的服务器,支持不同硬件,也能部署到OpenShift上,也可以部署到第三方的基础设施,灵活度很高。

红帽不只推出vLLM的新产品,也发布了一个新的开源项目llm-d,这个项目利用了红帽熟悉的K8s分布式架构,来执行各种分布式GenAI推论工作。红帽与许多重要GenAI技术巨头,像是Google、Nvidia等,联手发展这个用于提高大规模GenAI推论用的项目。

vLLM可以不同的加速芯片上执行,不只是Nvidia、AMD最新芯片,也能支持Google的TPU芯片。

根据红帽评估,同样的GenAI推论任务,在同样的加速芯片上,若使用vLLM技术,可以比原本做法提高2到4倍的Token吞吐量,等于在GenAI推论生成Token的能力,有可能提高到四倍。

而在新的llm-d项目中,可以进一步提高推论的Token生成能力。Chris Wright解释,利用K8s的调度能力,结合企业现代化IT的能力和GenAI推论能力,就像K8s将分布式架构带来了Linux服务器,llm-d项目也同样将分布式架构带来了LLM服务器,提供了一种分布式推理的能力。“单一推理请求,可以由整个从集中多个加速芯片来共同生成。”Chris Wright强调:“这是一种可以过推理吞吐量提高超过10倍的新架构。”

既有vLLM开源项目只能在单一服务器上执行,但llm-d可以将推论请求分散到多个vLLM引擎上,甚至分配到没有充分利用的加速芯片上,也能将推论快速分散到多个存储层,“不只可以让AI应用跑得更快,还能降低整体成本。”这正是红帽瞄准生成式AI浪潮的新战略布局,瞄准企业大规模AI推论需求。

“2025将是AI推理的关键发展年,企业的AI产品真正开始进入大规模发展的关键时刻。”Chris Wright兴奋的说。