根据韩媒报道,韩国科学技术院(KAIST)电机工程系教授Kim Joung-ho(在韩国媒体中被誉为“HBM之父”)表示,高带宽闪存(High Bandwidth Flash,HBF)有望成为下一代AI时代的重要内存技术,将与高带宽内存(HBM)并行发展,共同推动芯片大厂的业绩增长。

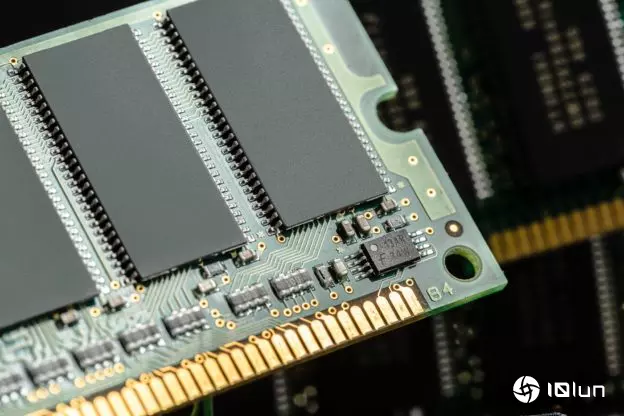

HBF的设计概念与HBM相似,皆通过硅穿孔(TSV)将多层芯片堆栈连接。差别在于HBM以DRAM为核心,而HBF则采用NAND闪存进行堆栈,具备“容量更大、成本更具优势”的特点。Kim Joung-ho指出,虽然NAND的速度不及DRAM,但容量往往高出10倍以上,若以数百层乃至数千层堆栈方式构建,将能有效满足AI模型对庞大存储的需求,有望成为NAND版本的HBM。

目前生成式AI模型正急速扩张,单一模型的输入token已达百万级别,处理过程需要TB级数据。在每秒数千次的读写过程中,若内存带宽不足,就会出现瓶颈,导致ChatGPT、Google Gemini等大型语言模型(LLM)的反应速度明显下降。

Kim Joung-ho强调,这种限制来自现行的冯诺依曼架构,由于GPU与内存是分离设计,数据传输带宽决定了性能上限,“即便将GPU规模扩大一倍,如果带宽不足也毫无意义”。

他预测,未来GPU将同时搭载HBM与HBF,形成互补架构:HBM作为高速缓存,负责即时运算数据,而HBF则承担大容量存储,直接存放完整的AI模型。这将有助于突破内存瓶颈,使GPU能处理更庞大的生成式AI,甚至涵盖长篇视频等复杂内容。Kim Joung-ho表示:“未来AI将不仅限于文本与图像,而能生成如电影般的长片,届时所需的内存容量将是现有的1,000倍以上。”

(首图为示意图,来源:Image by Freepik)