在AWS re:Invent 2025的《基础设施创新》主题演讲中,AWS计算与机器学习服务副总裁Dave Brown发布了一系列重磅技术,包括AWS Graviton5(预览)、AWS Lambda Managed Instances以及专为AI推理打造的Project Mantle,引起企业与开发者广泛关注。

Brown表示,AI如何推动企业加速创新是一条已确立的路,而AWS的角色是确保企业可用最具性价比、最省力的方式运行推理与训练工作负载。

AWS全新自研处理器Graviton5(预览)是本次发布重点。其在单封装中提供192核心,完全无需跨CPU互联,结合5倍L3缓存提升与更高效散热设计,使M9g执行实例性能比前代M8g再升25%。

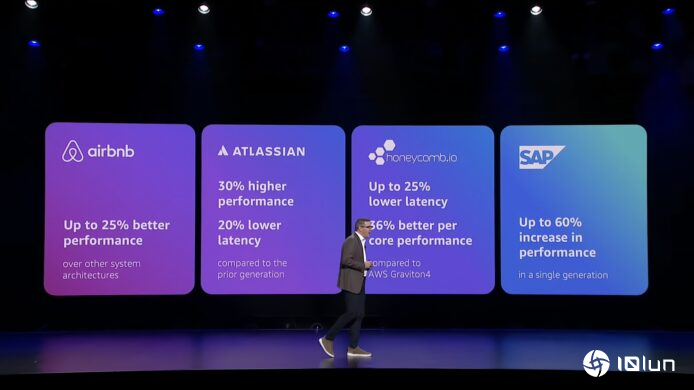

多家企业已在生产环境中验证其性能,包括Airbnb(+25%)、Atlassian(延迟 -20%)、SAP HANA(OLTP查询性能 +60%)。Apple更分享其核心后端服务迁移至Graviton后,性能提升40%、成本降低30%。

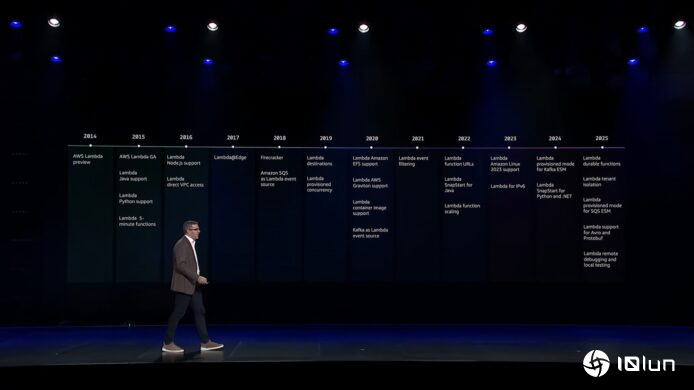

AWS Lambda问世十年后,AWS宣布推出Lambda Managed Instances,让开发者以Serverless方式运行在EC2上的工作负载。客户可自由选择硬件与执行实例类型,而AWS负责配置、缓存、扩展与可用性管理。

这项创新特别适合视频处理、ML前处理与高吞吐量分析等以往不适合Lambda的场景,实现“Serverless与基础设施控制兼得”的新运算模式。

AI推理过程包括分词、预填充、解码、去分词,每个阶段对CPU、GPU、内存及网络需求都不同。Brown指出,以传统基础设施架构处理这类动态、瞬变的需求并不理想,因此AWS从零开始打造Project Mantle推理引擎,已成为Amazon Bedrock许多模型的核心底层。

Project Mantle引入三大创新:

此外,Mantle也加入机密运算保护模型权重与用户数据,使整体性能、延迟与利用率全面提升。

AWS宣布Amazon Nova多模态嵌入模型与S3 Vectors进一步集成,让企业可直接在S3内以原生方式存储数十亿级矢量。同时,OpenSearch与多个分析服务也加强矢量搜索能力,以支持语义查询、内容理解及RAG应用。

TwelveLabs使用Amazon S3 Vectors处理大量视频矢量,大幅降低架构复杂度,并提升应用的单位经济效益,成为代表性成功案例。

AWS也展示Trainium3 UltraServers的实际性能,包括:

而下一代Trainium4将于明年发布,官方承诺FP4运算性能提升6倍,内存带宽提升4倍。

Dave Brown指出,AI让云计算进入前所未有的变革期,而AWS的使命是替客户构建一个既具成本效率,又能应对全新推理负载的基础设施。无论企业在加速开发、语义搜索、模型推理或训练方面的需求如何演进,AWS都会持续在基础设施层进行深度创新。

他强调,下一个十年将是“Agentic AI”从概念走向全面落地的年代,而这一切的前提,是企业拥有一个足够强大、稳定且具弹性的云计算基础。