于2024年12月压轴登场的AWS re:Invent,其Monday Night Live节目分别有主讲嘉宾分享AWS在云计算及人工智能 (AI) 两大范畴的革新,其中AI无论是Claude的大型语言模型 (LLM) 抑或配备训练AI模型的硬件配置在过去一年都有长足发展。

很多常见的工作负载都是横向扩展的,例如Web服务和大数据程序。当添加更多硬件时,横向扩展工作负载可以非常有效率地运行系统的额外资源。AI工作负载则是纵向扩展的。这是因为训练AI模型的时候是以数据平行 (data parallelism) 的形式进行,如果有多个服务器同时参与训练,每个服务器将获派同等大小的数据用作训练,最后归纳好所有训练数据结果,才会派出下一项数据。当服务器越多的时候,归纳结果所需的时间就越高,令到横向扩展无法满足AI训练的需求。

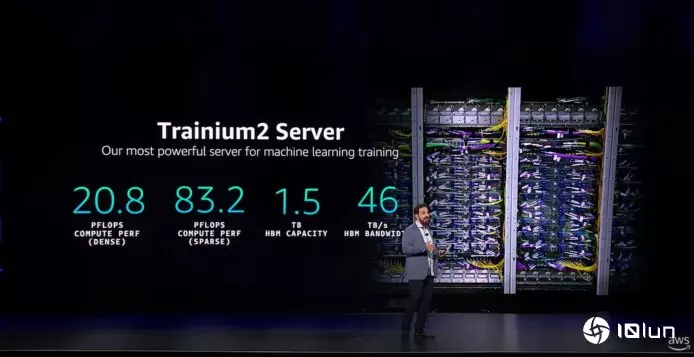

正因如此,训练AI需要以最小体积的硬件提供最多的运算性能。AWS也为此推出了新一代的AI芯片Trainium 2。它运用了先进封装技术,其中搭载2块运算芯片以及4个高带宽内存 (HBM) 模块。Trainium 2服务器也是AWS迄今为机器学习而设最强的服务器。

AWS自家开发出Trainium芯片互联技术NeuroLink,让Trainium 2可以高速连接以提供更强AI训练性能。连接技术支持高达每秒2TB传输,以及仅1微秒 (即0.001毫秒) 时延。AWS以此技术组合出多块Trainium2芯片,从而推出Trainium2 UltraServer,以两座机柜、四个服务器与64颗Trainium2组合而成。其配置达到83.2 PFLOPS,比起单个Trainium2 Server速度达4倍。

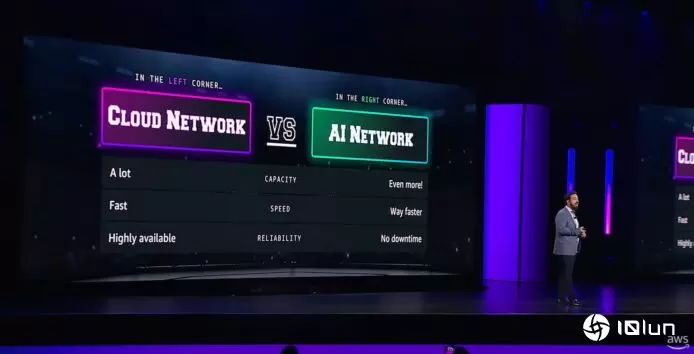

AWS了解到客户对AI网络要求比一般云计算网络要求更高,他们也因此在网络上创新,推出了10p10u网络,意味在上千台服务器间提供数十PB的网络传输能力,而时延也不到10微秒。同时他们将16条独立的光纤集成成预制光纤组件(Fiber optical trunk cable),直接在工厂组装,减少6成连接器数量之余,也大大降低接错线的问题,部署时间缩短近半。

Anthropic是其中一家首屈一举的AI模型开发企业,他们今年推出的Claude模型获得市场欢迎。他们一直以来与AWS紧密合作,他们也在活动中宣布会使用拥有数十万个Trainium2芯片的新AWS集群 (cluster) 训练新一代Claude模型,并命名项目为Project Rainier。

他们已于上个月发布了3.5 Haiku和升级版3.5 Sonnet。而新项目意味客户将能以更低价钱获得更强AI模型,而且速度也会更快。市场可以期待,不久将来会有更快及可信赖的AI面世,届时企业便可委托AI助理去完成更重要的项目。