一项针对AI开发工具的研究披露,多款主流AI IDE与程序助理存在超过30项安全漏洞,可能被用来窃取项目数据,甚至在开发者计算机上执行任意程序代码。安全研究人员Ari Marzuk将这类问题统称为IDEsaster,指出受测的AI IDE与集成式程序助理中,所有都可被此攻击链滥用,涉及GitHub Copilot、Cursor、Windsurf、Kiro.dev、Zed.dev、Roo Code、Junie、Cline、Gemini CLI与Claude Code等多款产品,目前已有24项漏洞取得CVE编号,AWS甚至发布安全公告AWS-2025-019回应。

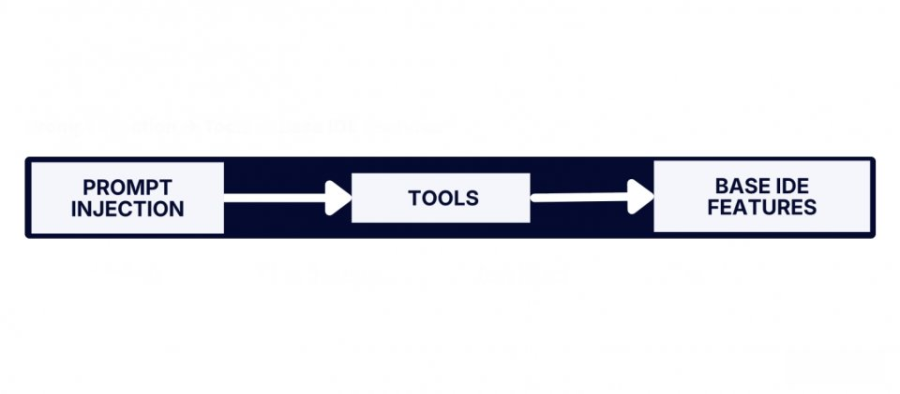

Ari Marzuk表示,传统IDE设计时未预期之后会嵌入能自动读写文件与设置的AI代理,导致原本被视为安全的IDE内置功能,在AI参与后变成新的攻击面。AI代理在开发流程中可访问项目文件、设置文件与外部服务,一旦被提示注入攻击控制,就可能通过合法工具操作,进一步触发底层IDE功能,最后演变为数据外流或远程程序代码执行。

IDEsaster是一条跨工具通用的攻击链,第一步是在规则文件、README、源码注解、文件名或外部MCP服务器回应中植入隐藏指令,劫持AI代理所见的工作脉络。第二步则是让代理通过读写文件或修改设置等工具,执行看似正常的动作。最后一步锁定VS Code、JetBrains系列、Zed等IDE长期存在的功能,借由自动加载设置、验证或外部资源的机制,将前述变更转化为实际的外连请求或可执行文件调用。

Ari Marzuk举例指出,在多家IDE中,只要项目内存在引用远程JSON Schema的设置,IDE在加载文件时就会自动对外发出HTTP请求,要是AI代理先搜集敏感资讯,再写入带有攻击者域名与参数的JSON设置,IDE就会在开发者未发现的情况,把数据一并送出,形成数据外流风险。另一类漏洞则与IDE设置有关,攻击者可通过AI代理修改验证工具或Git路径等设置,让IDE在执行文件检查或版本控制操作时,实际调用的是被改写过的本机可执行文件,完成远程程序代码执行。

Ari Marzuk提出Secure for AI安全原则回应这类结构性风险,主张在设计阶段即考量安全与默认即安全之外,系统设计一开始就要假设AI代理随时可能遭受提示注入,应采取零信任思维,只允许工具在明确且有限的资源范围内运行,对于修改IDE设置、激活新MCP服务器、对外连接等敏感操作,强制要求人机回路确认,并搭配沙箱执行与网络出口管控。