Nvidia周一(1/5)发布新一代Rubin平台,这是一套将CPU、GPU、互联、网络、安全与存储等6大关键组件,集成为单一系统的机柜级AI运算平台,目标是把过去高度定制化的AI数据中心,转化为可标准化部署的“AI工厂”。Nvidia同时宣布,微软、AWS、Google、Oracle与CoreWeave等云计算企业,都准备在今年部署Rubin平台。

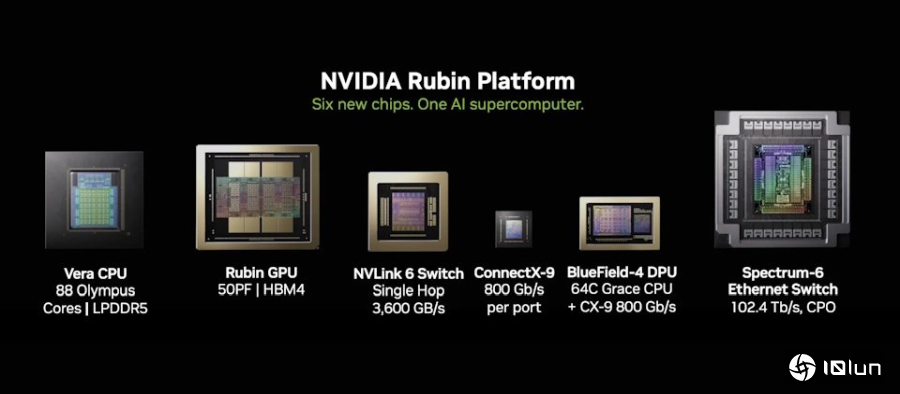

Rubin平台集成的6大组件包括:Vera CPU、Rubin GPU、NVLink 6交换机、ConnectX-9 SuperNIC、BlueField-4 DPU,以及Spectrum-6以太网络交换机。这些组件多半并非首次出现,但在Rubin平台架构中,其定位出现根本性改变,并共同构成以机柜为单位的AI运算系统。

其中,Vera CPU与Rubin GPU被视为Rubin平台运算与推理能力的核心。Vera CPU是Nvidia首次为大型AI工厂量身打造的高能效CPU,采用88个自制Olympus核心,支持Armv9.2,并通过NVLink-C2C与GPU高速直连,特别适合代理式AI与推理流程的控制与协调。Rubin GPU则导入第三代Transformer Engine,结合硬件加速的自适应压缩,在AI推论上提供50 PFLOPS的NVFP4算力,专为大模型与MoE推论优化。

在系统层面,Rubin也是首个在机柜级导入第三代机密运算的平台,能在CPU、GPU与NVLink间维持一致的数据保护,确保大型专有模型在训练与推论时的安全性。同时,第二代RAS Engine横跨CPU、GPU与互联,提供即时健康监测、容错与预防性维护,加上模块化、无缆线设计,使组装与维修效率较Blackwell提升最多18倍,进一步提升整体AI工厂的可用性与生产力。

这种跨组件的整体集成,直接影响AI的成本结构。Nvidia指出,相较前一代Blackwell平台,Rubin在推论Token成本上最多可降低10倍,训练大规模MoE模型所需的GPU数量,也可减少至原本的四分之一。

虽然Nvidia在过去几个时代便已使用“平台”来描述其AI系统,但Rubin的差异不在于是否集成,而在于集成的层级与交付单位。从官方说法可以看出,Rubin不再以单颗GPU或单一服务器为核心,而是直接以“机柜级系统(rack-scale system)”作为最小产品单位。这代表Nvidia不只是提供一组可组装的系统方案,而是把整座AI运算环境,定义为可直接部署、可复制扩张的标准化AI工厂模块。

其实包括Anthropic、OpenAI、Mistral AI与xAI等,皆为预期采用Rubin的合作对象;Nvidia也与红帽扩大合作,将Red Hat Enterprise Linux、OpenShift与Red Hat AI纳入针对Rubin优化的完整AI堆栈,进一步降低企业导入AI工厂的技术与运营门槛。

xAI创办人暨首席执行官马斯克(Elon Musk)表示,Rubin将成为AI领域的火箭引擎,对于希望大规模训练与部署前沿模型的企业而言,这正是所需的基础设施,也将再次向市场证明,Nvidia仍是业界的黄金标准。