Intel首席执行官Pat Gelsinger在Vision 24大会宣布与合作伙伴共建AI开放平台,并展示RAG技术,让现有大型语言模型能够搭配具有新资讯的数据库,快速更新AI的“认知”。

目前使用大型语言模型(Large Language Model,以下简称LLM)的一大问题,就是LLM仅拥有的训练当下所输入的资讯,而对于训练之后所发生的事件一无所知。举例来说,使用截至2023年的数据所训练的LLM,可能很擅长回答2022年的资讯,但若询问2024年的资讯,可能就会出现错误甚至得到“无法回答”的结果。

然而加入新数据并重新训练LLM并不是件简单的事,过程需要花费许多时间与电力(意味着高额电费或是服务器租赁费用),若以每月或是每周的频率重新训练,将衍生沉重的成本负担。

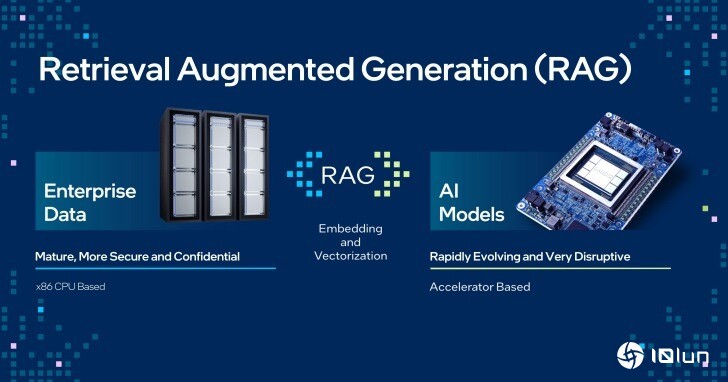

而检索增强生成(Retrieval Augmented Generation,以下简称RAG)则是能在现有LLM之上“插件”包含有新数据、文件、文件的数据库,让LLM能够自动从数据库寻找资讯,简化加入新数据的工作流程。

另一方面Intel也携手Anyscale、DataStax、Domino、Hugging Face、KX Systems、MariaDB、MinIO、Qdrant、RedHat、Redis、SAP、SAS、VMware、Yellowbrick和Zilliz等合作伙伴,宣布创建适合企业AI的开放平台,协助企业快速导入LLM与各种AI解决方案。

企业AI开放平台也能与RAG相辅相成,企业能够下载开放的LLM搭配私有数据库,并集成为能够回答包含私有资讯的聊天机器人,实现效益更高的部署便利性、最佳性能和价值,并且落实在本地端进行AI推论以降低安全风险,强化企业的生成式AI应用。

检索增强生成(Retrieval Augmented Generation,RAG)能够让现有LLM“读取”新数据库的资讯,达到快速追加新数据的效果。

检索增强生成(Retrieval Augmented Generation,RAG)能够让现有LLM“读取”新数据库的资讯,达到快速追加新数据的效果。

Intel携手众多合作伙伴创建适合企业AI的开放平台。

Intel携手众多合作伙伴创建适合企业AI的开放平台。

Pat Gelsinger也在Vision 24大会演说上进行RAG的实际展示,展现RAG能够协助用户爬梳资讯,由数据库中的文件文件找出具有参考价值的回答。

Vision 24大会演说进行的RAG实际展示,展示平台为执行于Gaudi 2加速器上的Llama 2 70B模型。(可参考重播视频的3:30开始段落)

Vision 24大会演说进行的RAG实际展示,展示平台为执行于Gaudi 2加速器上的Llama 2 70B模型。(可参考重播视频的3:30开始段落)

当被询问到Vision 24大会中RAG段落的资讯时,左方的纯Llama 2 70B模型回应不知道资讯,然后列出RAG的解释。右方的Llama 2 70B模型搭配RAG则能在数据库中找到演说数据,并列出数据源的参考文件。

当被询问到Vision 24大会中RAG段落的资讯时,左方的纯Llama 2 70B模型回应不知道资讯,然后列出RAG的解释。右方的Llama 2 70B模型搭配RAG则能在数据库中找到演说数据,并列出数据源的参考文件。

将画面放大看,搭配RAG的情况下能够回答演说的日期、时间、地点等资讯。

将画面放大看,搭配RAG的情况下能够回答演说的日期、时间、地点等资讯。

接下来询问RAG搭配Gaudi 2加速器与Xeon处理器能带来的TCO效益,纯Llama 2 70B模型回应相当冗长,但资讯并不是十分实用。Pat Gelsinger开玩笑说跟他的一位叔叔一样,讲了半天但是没有重点。

接下来询问RAG搭配Gaudi 2加速器与Xeon处理器能带来的TCO效益,纯Llama 2 70B模型回应相当冗长,但资讯并不是十分实用。Pat Gelsinger开玩笑说跟他的一位叔叔一样,讲了半天但是没有重点。

搭配RAG则是清楚回应能够提供1.5倍相对于NVIDIA H100平台的TCO优势。

搭配RAG则是清楚回应能够提供1.5倍相对于NVIDIA H100平台的TCO优势。

接下才测试输入提示词对回答造成的影响,先输入你有AI软件市场增长的预估数据吗(Do you have forecast data for AI software market revenue growth?)。

接下才测试输入提示词对回答造成的影响,先输入你有AI软件市场增长的预估数据吗(Do you have forecast data for AI software market revenue growth?)。

接下来将问题原文的数据(data)改为资讯(inforamtion),纯Llama 2 70B模型的2次回答南辕北辙,而搭配RAG则回答相同,能够降低不同提示词所造成的回答偏差。

接下来将问题原文的数据(data)改为资讯(inforamtion),纯Llama 2 70B模型的2次回答南辕北辙,而搭配RAG则回答相同,能够降低不同提示词所造成的回答偏差。

有兴趣了解更多资讯的读者,可以到Intel官方网站观看Vision 24大会演说的精华片段,以及更多技术展示。