近期,韩国高等科学技术院(KAIST)与TB级互联与封装实验室(TERA Lab)共同预测未来十年内AI GPU加速卡及高带宽内存(HBM)的发展趋势,部分数据之夸张程度,让人不禁质疑“真的走得下去吗?”

目前最先进的HBM技术是HBM3E,NVIDIA B300系列、AMD MI350系列的配置容量最高达288GB。而接下来的HBM4时代,预计NVIDIA Rubin系列将支持到384GB,AMD MI400系列则挑战432GB。

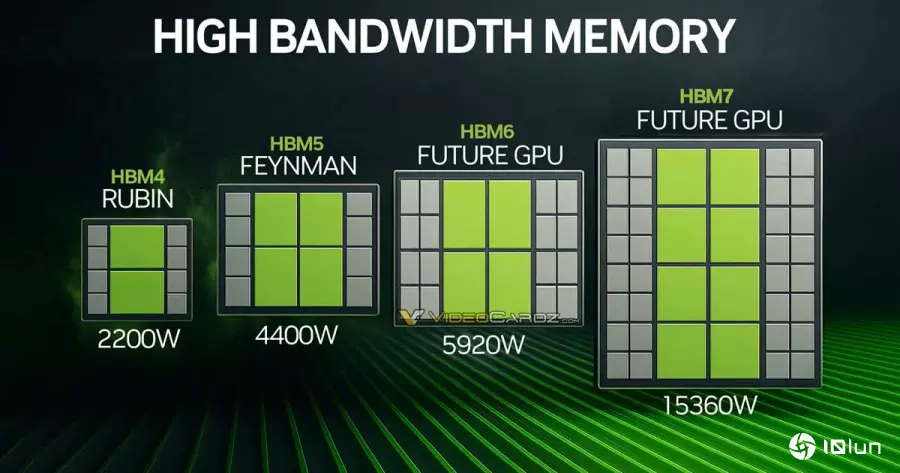

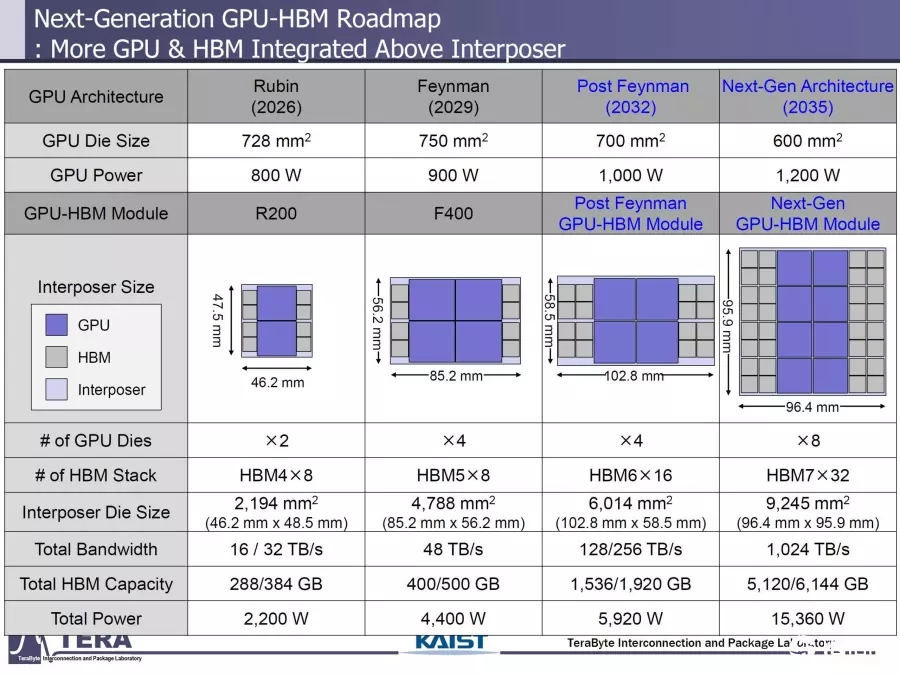

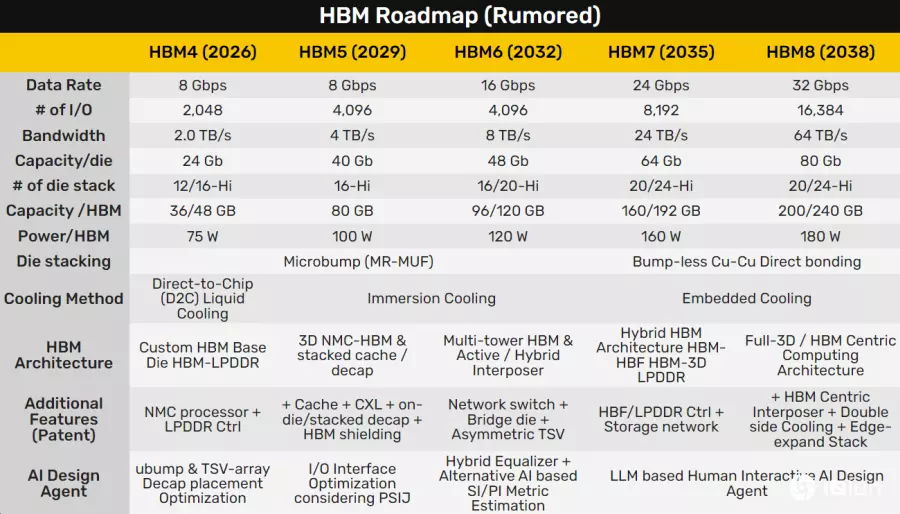

再往后的标准尚未定案,但预估HBM5可达400~500GB,HBM6则可能推升至1.5~1.9TB(1536~1920GB),甚至HBM7更可能突破至4.2~6TB(5120~6144GB)!

据传,NVIDIA Rubin将于明年登场,芯片面积达728平方毫米,单颗功耗高达800W,双芯片封装后的整体功耗可能达2200W,搭配8颗HBM4内存,总带宽达32TB/s。

目前AMD MI350系列的风冷版本已达1000W,水冷版更达1400W,NVIDIA B300也毫不逊色,功耗同样冲到1400W。

接着是预计2029年推出、代号Feyman的下一代NVIDIA AI GPU。根据推测,其单颗功耗将达900W,采四芯片集成封装,整卡面积高达4800平方毫米,搭配8颗HBM5、带宽达48TB/s,整卡总功耗预估会达到惊人的4400W。

未来还有更激进的规格预测——2032年将问世的新一代GPU,单芯片面积虽缩小为700平方毫米,但单颗功耗突破1000W,搭载16颗HBM6、总带宽256TB/s,整卡功耗可能高达6000W!

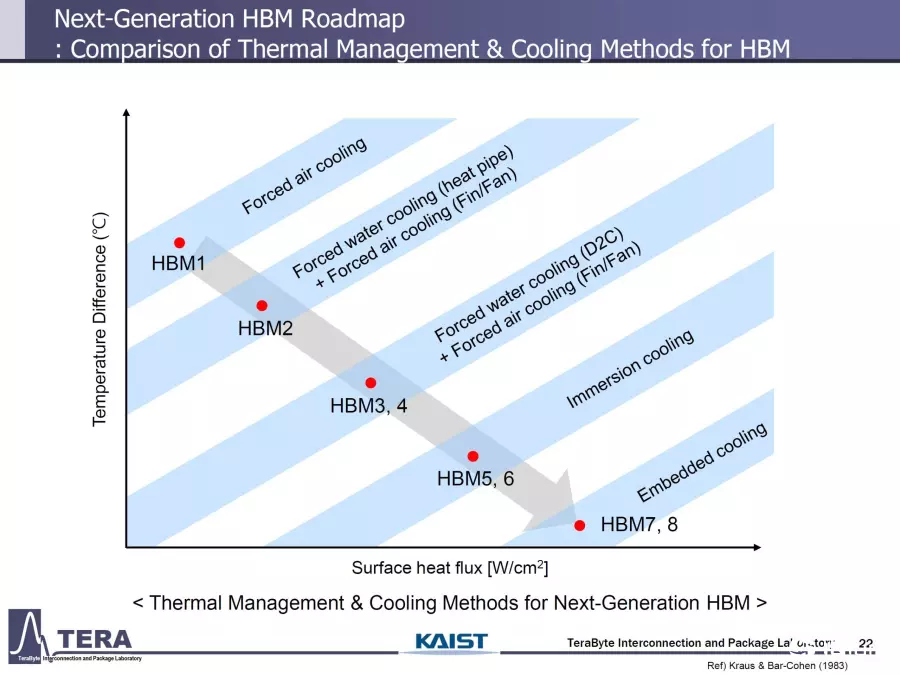

最夸张的是2035年预估推出的新架构:单芯片面积进一步缩至600平方毫米,单颗功耗达1200W,并首度采用八芯片封装,中介层面积超过9000平方毫米,搭配32颗HBM7,带宽可达1TB/s,整卡功耗竟高达15,000W!

这样下去,难道每座数据中心旁都得兴建一座核电厂来供电?AI的进化之路,恐怕也得先面对能源的极限。