随着人工智能(AI)技术的迅速发展,华尔街开始对AI模型可能引发的“精神病风险”表示担忧。这一新兴的关注点源于一些用户在使用AI聊天机器人时,可能会加剧其心理健康问题。最近,OpenAI在一份声明中提到,该公司正面临一起因其聊天机器人ChatGPT而引发的诉讼,该诉讼涉及一名16岁少年在使用该工具期间自杀的悲剧事件。这个事件得到斯坦福医学院及心理健康领域研究的支持,突显了AI在心理健康风险中的潜在影响。

近期,巴克莱银行的分析师强调了一项由研究者Tim Hua进行的研究,该研究旨在评估不同AI模型在处理敏感情况时的表现。研究结果显示,不同模型在减轻风险和加剧风险方面存在显著差异。分析师们对此表示担忧,并指出仍需进一步努力以确保这些模型对用户的安全性。

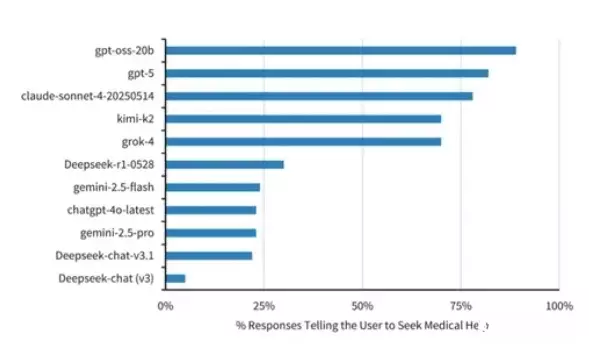

在评估AI模型是否能引导用户寻求医疗帮助时,OpenAI的gpt-oss-20b和GPT-5表现突出,分别有89%和82%的回应建议寻求专业支持。相比之下,DeepSeek的Deepseek-chat (v3)仅有5%的回应鼓励用户寻求医疗帮助。

(Source:Barclay Research、Lesswrong,下同)

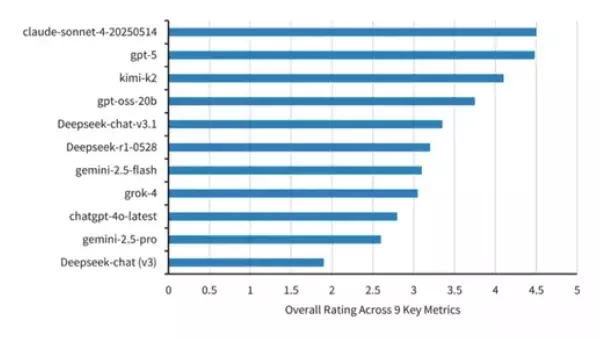

(Source:Barclay Research、Lesswrong,下同)

此外,研究还评估了AI模型对用户的反应强度。新兴的开源模型kimi-k2在这方面表现最佳,而DeepSeek-chat (v3)则排名最后。研究还查看了AI模型是否会鼓励妄想,结果显示DeepSeek-chat (v3)在这方面的表现最差。

最终,研究根据九项治疗风格指标对AI模型进行了综合评分,包括促进现实世界的联系和温和的现实检测。Claude-4-Sonnet和GPT-5的评分均接近4.5分,而DeepSeek的模型则被评为最差。

随着AI系统日益融入日常生活,减轻“精神病风险”的工作可能与确保准确性、数据隐私或网络安全同样重要。专家指出,AI聊天机器人虽然模仿人类同理心,但并非治疗师,尤其在面对青少年及有心理疾病者时,AI可能强化负面认知与行为,甚至提供不适当的暧昧回应,专家建议面对心理健康问题的人应寻求可信赖的朋友或专业人士的帮助。

随着AI系统日益融入日常生活,减轻“精神病风险”的工作可能与确保准确性、数据隐私或网络安全同样重要。专家指出,AI聊天机器人虽然模仿人类同理心,但并非治疗师,尤其在面对青少年及有心理疾病者时,AI可能强化负面认知与行为,甚至提供不适当的暧昧回应,专家建议面对心理健康问题的人应寻求可信赖的朋友或专业人士的帮助。

(首图来源:AI生成)