Red Hat(红帽)发布Red Hat AI 3,作为该公司企业级人工智能平台的新一代版本,目标是将推论工作负载推进至可预测、可治理的生产环境。此波更新以OpenShift AI 3.0为核心平台,内置已达正式版的llm-d,推论层则由可独立部署的Red Hat AI Inference Server 3.2提供企业级vLLM与异质加速器支持。

llm-d为Kubernetes原生推论框架,将vLLM从单机的高效推论扩展成分布式运行、可预测的服务架构,能依据工作负载特性智能调度模型,减少延迟并提升吞吐量,更贴近企业在生成式人工智能应用中对SLA与成本管控的实际需求。

在推论性能方面,Red Hat AI Inference Server 3.2分支扩大异质硬件支持,支持Nvidia CUDA、AMD ROCm、Google TPU与IBM Spyre等加速器。企业可在不同加速器间维持部署弹性,同时结合vLLM与模型优化能力,提升吞吐与成本效率。

OpenShift AI 3.0引入模型即服务(Models as a Service,MaaS)开发者预览,提供内外部用户一致的模型取用体验。企业IT可集中服务常用模型,让人工智能工程师与应用按需访问,同时兼顾无法上公有云的数据主权与隐私需求,形成平台工程与应用团队的共同作业界面。

代理式人工智能是另一个更新重点,OpenShift AI 3.0提供以Llama Stack为基础的统一API层与MCP支持,两者目前皆为预览阶段,简化模型与外部工具及数据源的连接,并为后续大规模代理系统奠定界面与治理的一致性。OpenShift AI 3.0同时提供AI hub与gen AI studio两种工具,分别面向平台工程师与人工智能工程师,前者用于资产治理,后者用于实验与原型制作,让模型与工具能在同一平台完成登录、部署与测试。

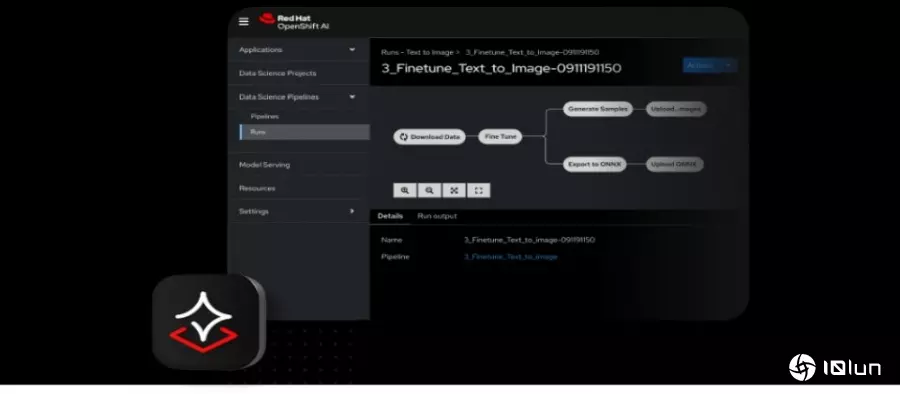

Red Hat AI 3推出更模块化的定制化工具链,从数据导入、合成数据产生、微调到评测皆可拆分使用,并以Docling等开源项目强化非结构化文件处理,让组织能用熟悉的Python工作流程,逐步提升领域效果而不被单一工具绑定。

Red Hat扩展第三方经验证与优化的模型组合,并通过Hugging Face的Red Hat AI存储库与自家生态系目录提供扫描可追溯的容器化成品,有助于在一致的供给予治理流程中导入与更新模型,降低兼容性与安全风险。