Apple最新研究显示,原本用于语音识别的AI模型可通过处理心音图来判断用户心率,这项技术有望应用于未来AirPods产品。

Apple最近发布题为“基础模型隐藏表征用于听诊心率估算”的研究报告,探讨如何运用基础模型从音频记录中测定心率,即使这些模型原本并非为此目的而设计。他们测试了6个热门基础模型,包括用于音频转录的Whisper,以及一个内部开发的CLAP(对比语言音频预训练)模型。研究人员让这些模型处理心音图记录而非语音内容,总计约20小时的心跳声音数据。

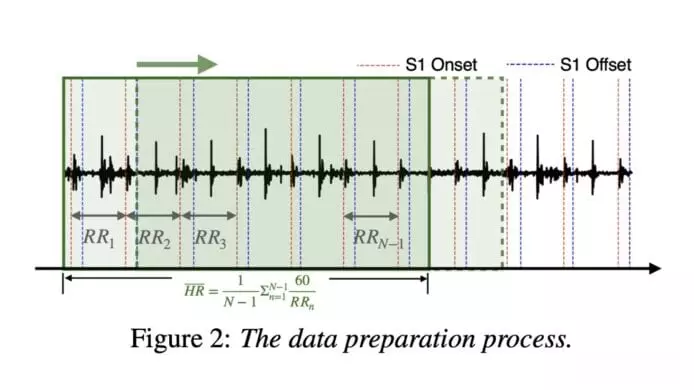

测试采用公开的CirCor DigiScope心音图数据集,录音长度由5.1秒至64.5秒不等。人工标注员为心音图音频文件中的心脏杂音作出标记,并将文件分割成每秒移动的5秒片段,最终产生23381个心跳声音片段用于转换成心率测量数据。

研究结果显示Apple内部CLAP模型表现比其他现有模型优秀:“我们观察到内部CLAP模型音频编码器的表征在各种数据分割中达到最低平均绝对误差,超越了使用标准声学特征训练的基准模型。”与Whisper、wav2vec2和wavLM不同,Apple内部CLAP模型使用包含语音以外内容的音频数据进行训练。

多样化的训练数据“可能增强其捕捉与心跳声音相关的非语音特征能力,有助提升其效果”。研究人员指出,为语音处理而创建的基础模型“可有效适应听诊和生命体征估算,为部分传统方法提供稳健且高效的替代方案”。

研究同时发现较大型基础模型未必在心率判断方面表现更佳。研究指出,基础模型的额外微调可能带来更准确的心率估算。研究人员认为这项技术在“心肺声音病理分析方面具有潜在应用价值,可能有助更准确检测心律不齐和杂音等异常情况”。

考虑到Apple对健康相关功能的重视,可能会将此技术集成至未来AirPods型号。现在AirPods Pro 2已支持一系列听力健康功能,并通过内置麦克风提供主动降噪功能。之前已有传言指Apple正研究在AirPods中加入心率和温度传感器等功能,是否会实际推出新功能仍然有待进一步公布。

来源:Apple Insider