由于目前大型语言模型的性能,主要依赖大量的训练计算资源,而正是这种昂贵的成本模式,驱使开发公司寻求替代方案。而Hugging Face的研究显示,通过测试阶段运算扩展(Test-Time Compute Scaling),小型模型在推理过程中给予足够的运算时间,能针对复杂问题进行多次尝试或修正,性能不仅提升,甚至可在数学推理等特定任务中超越大型模型。这项成果挑战了过去以模型规模作为性能提升主要依据的认知,展现了小型模型在资源有效利用下的潜力。

测试阶段运算扩展已成为许多研究机构关注的技术,其中DeepMind的研究显示,借由动态分配测试阶段计算资源,可以让模型在解决复杂问题时更具效率。DeepMind研究人员提出了使用验证搜索解答空间的策略,验证器能对模型的中间推理解答给出评分,并引导搜索过程朝正确方向推进。DeepMind的实验证实,测试阶段运算策略能让小型模型在部分复杂任务中超越其基础性能。

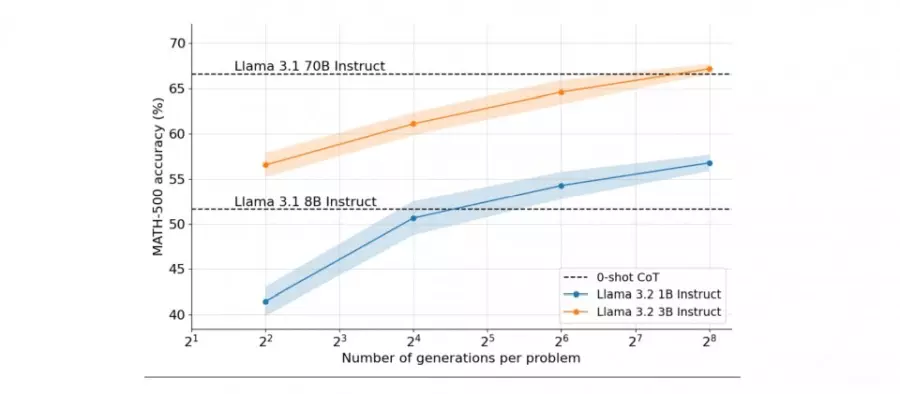

而Hugging Face的研究更聚焦于开放模型与资源的应用,并提出多样性验证树搜索(Diverse Verifier Tree Search,DVTS)这种改进验证器搜索方法的技术。DVTS有效解决了搜索过程中的多样性不足问题,特别是在高计算资源配置下,其生成的解答在准确性和多样性上表现更佳。通过这些测试阶段运算扩展技术,Hugging Face展示小型模型在数学推理等特定任务中,足以挑战甚至超越大型模型,颠覆过去依赖模型规模决定性能的传统观点。

简单来说,DeepMind的研究主要说明,通过动态分配测试阶段的计算资源,小型模型可以在多一点运算时间下,提升性能并表现得更好。Hugging Face的研究则进一步延伸,提出在某些特定任务中,给小型模型足够的运算时间,不仅能提升性能,甚至可以超越参数量更大的模型。

Hugging Face的DVTS针对搜索策略中的多样性问题进行优化,借由分离多个搜索树,提升生成答案的多样性并避免单一路径过度主导搜索过程的现象。在数学基准测试中,小型模型如参数量仅为10亿的Llama模型,在应用DVTS策略后,解题表现不仅超越了自身基础能力,甚至在某些场景中超越了参数量高达70亿的大型模型。

不过目前这些技术的发展仍受限制,因为验证器的能力目前局限于数学和程序代码等可验证领域,要将这些技术应用于需要主观判断,或是难以量化的任务,仍需要更多后续研究。不过从实务角度来看,测试阶段运算扩展的成功,对模型性能提升提供了更具成本效益的方法,让企业能以更少的资源部署更高效的语言模型,特别是在运算能力受限的环境下,如边缘运算或嵌入式系统等。