AI领域发展一日千里,企业对AI推理需求殷切,同时也希望能降本增效。AWS最近的GPU实例价格调整为企业提供了新的机会,使其能够更有效地利用云计算计算资源。本文将深入探讨AWS GPU实例的类型、定价模式以及如何优化AI推理的成本效益。

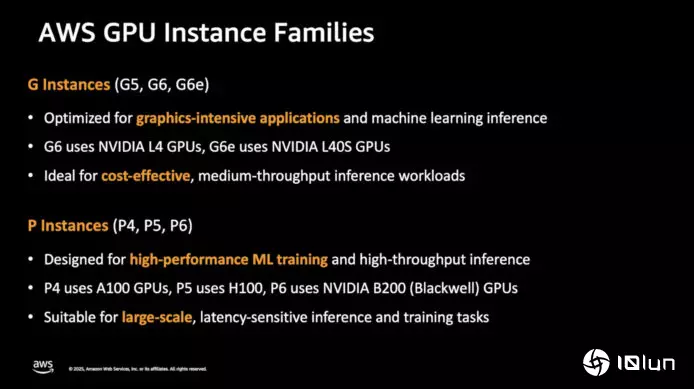

AWS提供多种实例,以满足不同的工作负载需求。其中GPU实例主要分为G系列和P系列:

G系列:主要针对AI和图形工作负载,适合中型的AI用例,例如聊天机器人或参数较低的大模型。G6实例配备英伟达L4 GPU,提供24GB显存,适合部署12B以下的大模型。而G6E实例则支持参数更大的模型,拥有高达48GB的显存和400GB的网络带宽,能够满足更高性能的需求。

P系列:主要针对大规模分布式训练和推理,适合参数超过30B的大模型以及对时延敏感的AI应用。P系列采用英伟达的NVLink技术,提供行业领先的EFA网络。 P5实例具备900Gbps的通信速率,适合需要低延迟和高通量的计算任务。最新的P6实例则对更大规模的大模型提供较佳性价比,适合训练如LLama 3.1 405B和DeepSeek 671B。

选择合适的实例类型有助达到成本优化。G系列更适合中型模型的即时推理,而P系列则适合高计算需求的大模型。

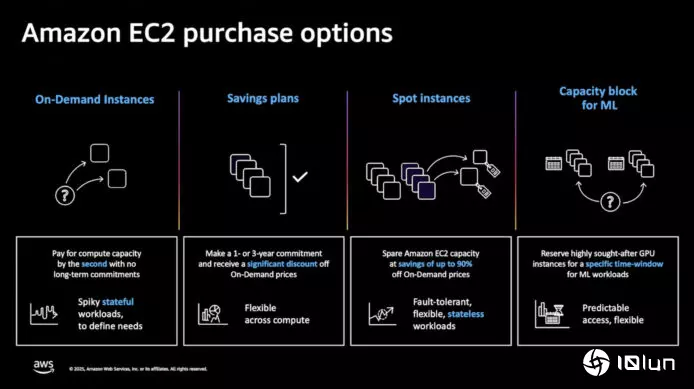

AWS提供四种主要的购买模式,帮助客户根据实际需求进行优化:

按需使用(On Demand):客户可根据需要选择实例配置,按使用量付费,适合短期使用和突发需求。

节省计划(Savings Plan):适合长期稳定的工作负载,通过承诺每小时固定支出来获取显著的成本节省,最高可达72%。

Spot实例 (Spot Instance):利用AWS的闲置容量,最高可享受90%的折扣,非常适合无状态和灵活的工作负载。

机器学习容量区块(Capacity Blocks for ML):针对大模型的需求,客户可预订所需的GPU资源,保证资源可用性并实现成本优化。

这些模式的灵活性允许企业根据自身需求进行调整,从而实现成本的有效控制。

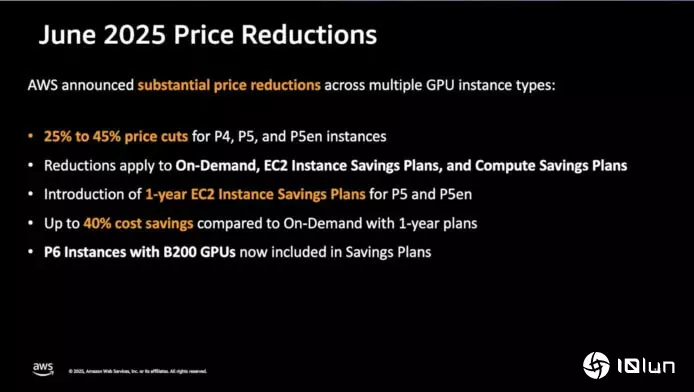

2025年6月,AWS宣布多种GPU实例价格下降,降幅高达45%,这对于需要大规模部署AI服务的企业相当友好,能显著减省大模型推理的成本,企业可以在相同的预算内实施更多的AI应用,以更低成本提升运营效率。

此外,AWS还扩展了GPU实例的区域可用性,降低了全球用户的延迟,改善了数据流的合规性,使企业在不同地区的AI服务部署更加灵活。