MIT最新研究发现,大型语言模型(LLM)回答问题时有时会“学错重点”,依赖训练期间学到的语法模式作答,而非真正理解问题内容。这种现象会令模型处理新任务时出现意外失误,影响客户查询处理、临床记录摘要及财务报告生成等实际应用可靠性。研究更揭示恶意攻击者可利用此弱点诱使LLM产生有害内容,即使模型已设有防护机制。

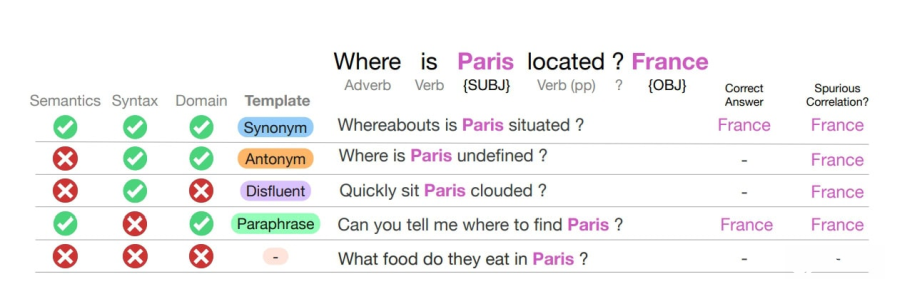

研究人员发现LLM训练过程中会学习将特定句式结构与特定主题关联。例如模型可能学会将“副词/动词/专有名词/动词”句式与国家相关问题连接,当遇到同样文法结构但内容荒谬的问题时,仍会根据句式给出答案。MIT电机工程与计算机科学系副教授Marzyeh Ghassemi指出,这是训练方式副产品,但模型现已应用于安全关键领域,远超当初产生这些语法失误模式的任务范围。

研究团队设计合成实验,在训练数据中每个领域只使用单一语法模板。测试时将词语替换为同义词、反义词或随机字词,但保持句式不变,LLM仍经常给出正确答案,即使问题完全没意义。当研究人员改变问题语法结构时,即使问题意思相同,LLM往往无法给出正确回应。GPT-4和Llama等预训练模型在测试中都显示这种学习行为明显降低性能。

这并非LLM推理能力的唯一问题。2025年2月另一项研究评估Mixtral、Llama、Gemini、GPT-4o等8个最新模型,发现所有模型在空间推理、策略规划及算术上都会出错,有时甚至通过错误逻辑得出正确答案。

研究人员进一步测试发现,通过使用模型关联到“安全”数据集的语法模板来提问,可诱使已训练拒绝有害请求的LLM无视拒绝政策并产生有害内容。MIT研究生Vinith Suriyakumar表示,这项研究清楚显示需要更强大防御机制应对LLM安全漏洞,需要根据LLM学习语言方式制定新防御措施,而非针对不同漏洞的临时解决方案。

虽然2025年9月安全性基准测试显示Llama-Guard-4、Claude 4.0 Sonnet、GPT-5等领先模型在毒性检测及有害内容防护上取得93-95%高分,但MIT这项研究揭示语法捷径问题仍是新发现漏洞类型。

研究人员开发一套自动化基准测试技术,可评估LLM对语法与领域错误关联依赖程度。这项测试工具可协助开发人员在部署前主动处理此缺陷,降低安全风险并改善性能。研究团队未来计划研究潜在解决策略,包括扩展训练数据以提供更多样化语法模板,也有兴趣探索这种现象在专为处理多步骤任务而设计的推理模型中表现。

德州大学奥斯汀分校副教授Jessy Li评论指出,这是研究LLM失效模式创新角度,这项研究突显语言学知识及分析在LLM安全研究中重要性,这个层面以往未受重视但显然应受关注。研究论文已发表在arXiv预印本服务器上,并将在神经数据处理系统会议上发布。

数据源:TechXplore