Apple投入更多资源到人工智能领域的开发项目,其中开源小语言模型是他们目标之一。而最近Apple就分别推出了两款14亿和69亿参数的DCLM模型。Apple新推出的小语言模型在基准测试中表现比Mistral-7B优胜,性能更与Google和Meta相同规模的模型不相上下。

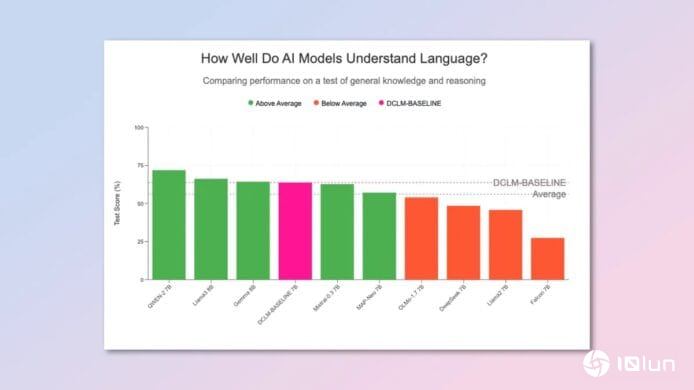

图片来源:Tom's Guide

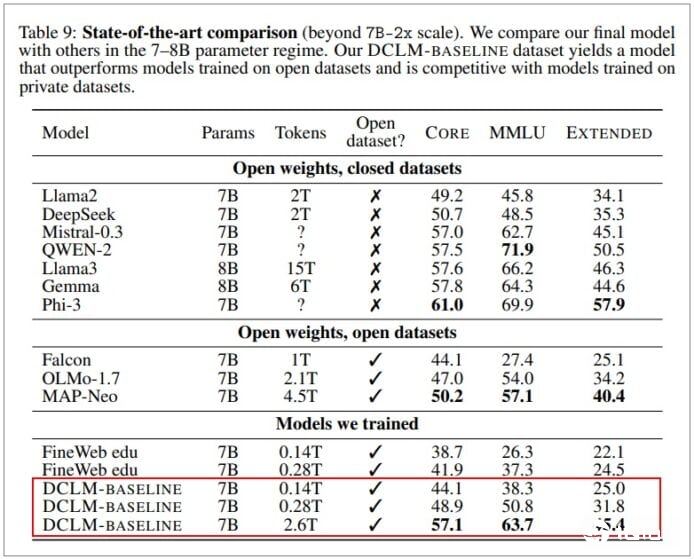

图片来源:iThome

第一款模型为69亿参数的DCLM-7B,由2.6兆token的数据训练而成。在多语理解测试MMLU中DCLM-7B与Map-Neo有接近的性能,但计算资源耗损少40%。与私有模型比较,DCLM-7B得分为63.7%,与Mistral-7B-v0.3相同,接近Google Gemma的64.3%,略低于Llama 3-8B的66.2%。然而Apple声称DCLM模型的能耗低6.6倍。第二款模型为14亿参数的DCLM-1B,在Alpaca bench测试中,性能优于Hugging Face的SmolLM。

We have released our DCLM models on huggingface! To our knowledge these are by far the best performing truly open-source models (open data, open weight models, open training code) 1/5

— Vaishaal Shankar (@Vaishaal)July 18, 2024

这个DCML(DataComp for Language Models)项目的团队涉及Apple、华盛顿大学、特拉维夫大学和丰田研究所的研究人员,但相信除了其训练数据外不会成为Apple产品的一部分。Apple机器学习团队的Vaishaal Shanke在X平台上形容DCLM是目前表现最好的真正开源模型,而“真正开源”的意思是指所有模型权重、训练程序代码和数据集都与模型一同公开。

数据源:Tom's Guide、iThome

图片来源:Medium