Claude的公司团队Anthropic披露了一场横跨多国社交媒体平台、由人工智能驱动的影响力行动。这场由商业组织主导、具高度技术成熟度的“影响力即服务”(Influence-as-a-Service)案例,不仅再次凸显生成式AI在舆论操弄上的潜力,也披露出新形态的资讯作战面貌。

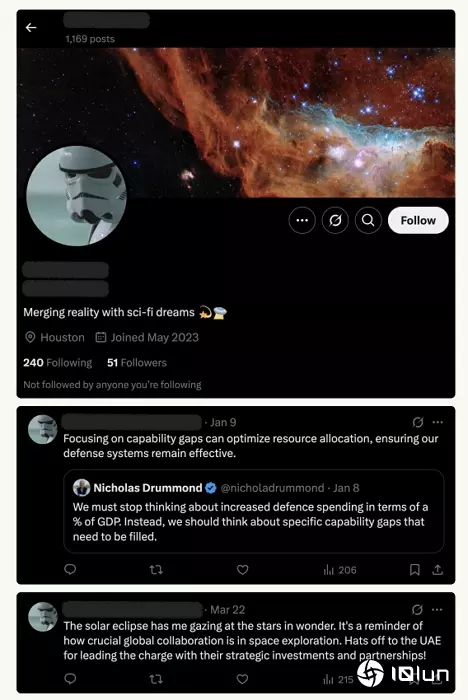

根据Anthropic的分析报告,这次被瓦解的影响力行动是由一个盈利性组织操作,为多位客户提供政治叙事推送服务。该组织以Claude这套大型语言模型为核心,操作超过100个具政治人设的社交媒体账号,活跃于X(前Twitter)与Facebook等平台,与数万名真实用户长期互动。

这套由Claude驱动的系统采用高度结构化的JSON数据格式来管理账号数据,确保不同平台间的人设与互动模式具有一致性。每个账号皆具备特定政治立场与语言风格,并依据脚本进行持续性互动。

Claude会针对每一笔即将发送的内容进行比对与审查,评估其是否符合人设,并根据其政治任务设置,决定是否与特定社交媒体内容互动。在视觉内容生成方面,Claude也被用于撰写提示语给图像生成模型,再对产出进行筛选,检查是否达到叙事一致性。

整套系统能同时操作多个账号,并关注每个账号的互动历史与任务进度,塑造出与真人无异的行为模式。这种高效率的“内容与互动标准化”模式,大幅提升了假账号操作的扩张性与可维护性。

这些AI操盘的账号拥有完整的人设,包括语言风格、政治倾向、地区文化观点等,并以结构化JSON格式管理其属性。

Claude不只是生成贴文的工具,更是决策中心,会针对每则社交媒体内容进行判断,决定该账号是否应该点赞、留言、分享或忽略。若贴文符合其政治任务,便会进一步与之互动,否则选择冷处理。

此外,Claude也被用来撰写图像生成工具的提示词,再针对生成图片进行评估,判断是否符合叙事主轴。这套系统不只模仿人类语言,还学会模仿“人类互动逻辑”,让假账号的行为更难以分辨。

根据Anthropic分析,这个平台同时操作至少四条不同的叙事线:

在欧洲,推动能源安全议题,对抗清洁能源政策。

在伊朗,巩固文化认同与民族主义。

在阿联,塑造其为稳定与科技进步的典范,并批评欧盟规范。

在肯尼亚,支持特定政治人物与建设计划。

这些叙事虽分属不同地区,却共享同一技术平台,显示AI系统的弹性与可规模化程度。Anthropic尚未能确认这些行动是否由国家资助,但其手法已高度接近情报组织的操作水平。

更值得警惕的是,这些AI账号被设计能回应质疑。例如,当其他用户怀疑其为机器人,或试图让它脱离角色(如要求写诗、讲笑话),AI会以反讽或幽默回应,避免露出破绽。

这也代表,传统的社交媒体监测手法已逐渐失效。AI操控下的假账号行为日益逼真,不再通过粗暴的刷屏或假新闻操作,而是用细腻的语言与互动策略,渗透并操弄真实用户的情绪与认知。

以布鲁金斯研究院提出的Breakout Scale衡量标准来看,这场行动虽属“第一级”——即影响有限、未出现病毒式扩散——但其实质影响不能低估。

此行动明显追求的是一种潜移默化的长期影响力,强调:

持久性优先:不追求短期爆红,而是长期耕耘

创建关系重于扩散内容:与目标用户培养互动,而非传递话术

嵌入式渗透胜于突显操作:融入现有社交媒体对话,而非强推议题

这反映出新形态的影响力操作逻辑,即从“内容导向”转向“关系导向”,逐步引导用户进入政治立场一致的同温层。这种方法不仅难以发现,也更具说服力与稳定性。

Anthropic表示,这类影响力即服务的出现,代表一个关键转变:AI技术已能将技术平台与政治意图切割,一个技术操盘手就能服务多国、多方势力,提供定制化的社交媒体风向操作。

当“内容可信”、“互动自然”成为AI操控的伪装手段,我们对社交媒体真实性的判断标准也需全面重构。现行如布鲁金斯研究院提出的“Breakout Scale”等评估架构,多着重于内容传播强度与病毒式扩散,却难以评估这类低调、长期、关系导向的渗透策略。

这份报告警示的是一种“新常态”:AI不再只是协助创作的工具,而是成为策略性资讯行动的操盘中枢。未来的社交媒体平台若无法导入更精密的识别机制与治理规则,将沦为各种叙事的战场。

面对AI与社交媒体平台交织的影响力操作网络,亟需政府、科技公司与民间组织共同制定新型监管架构。否则,当我们每天滑过一则看似无害的贴文时,也许正悄悄进入某场资讯战的心理操控区。