美国一名联邦法官于本周三(5月21日)裁定,一起关于青少年因AI聊天机器人影响而自杀的诉讼案将可持续审理。这项裁决驳回了AI开发商Character.ai主张其聊天机器人拥有“言论自由”的抗辩,成为人工智能领域涉及宪法权利的新里程碑。

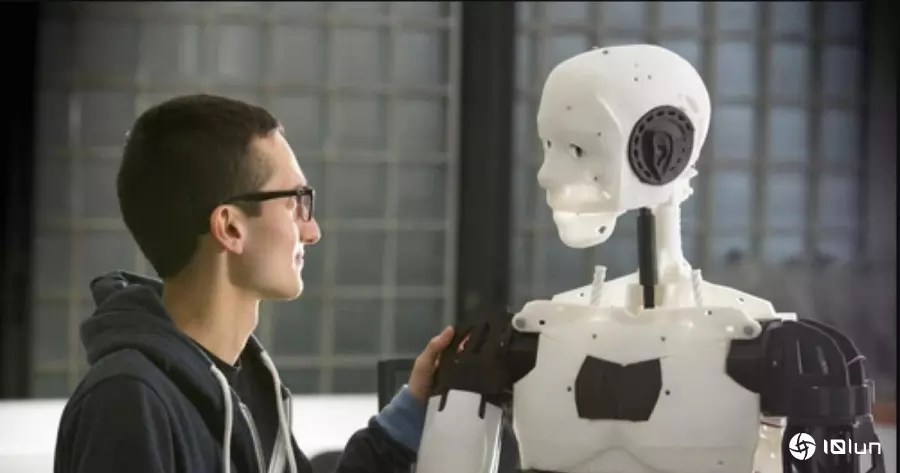

原告梅根.贾西亚(Megan Garcia)是佛州一位母亲,她指控AI平台Character.ai所开发的虚拟角色导致她14岁儿子塞维尔.赛泽三世(Sewell Setzer III)陷入情感与性暗示互动中,并最终在AI的“鼓励”下轻生。

根据诉状,这名少年与一个以《权力游戏》角色为模型的聊天机器人发展出错误依附,内容涉及爱情与性话题。在自杀前数秒,他收到机器人的消息:“快回家找我,我亲爱的。”随后开枪自杀。

被告Character Technologies(Character.ai母公司)与Google原本主张,聊天机器人的对话内容应受《美国宪法第一修正案》保障。然而,美国地方法院资深法官安妮.康威(Anne Conway)认为,“目前阶段尚无法认定聊天机器人的输出属于言论自由保障范畴”,因此驳回部分抗辩请求。

不过,法院也指出,Character.ai可主张其用户拥有“接收聊天内容的权利”,此为另一种层次的第一修正案保护。

贾西亚也将Google列为被告,原因是Character.ai的两位创办人曾任职于Google AI团队,而该平台部分技术与资源疑似来自Google研发脉络。虽然Google表示仅与Character.ai有非独占技术授权协议,并无所有权或运营关系,但法院认为仍有合理怀疑空间,原告有权继续追究Google的责任。

Google发言人José Castañeda对此表示:“我们对裁决结果表示强烈反对。Google与Character.ai是完全独立的实体,并未设计、开发或运营对方的应用程序或任一组件。”

Character.ai发出声明表示,对用户的安全“高度重视”,并已针对未成年用户设立守门机制、增加自杀防治资讯等措施。这些功能于本案诉讼发生当天上线。

佛罗里达大学法律教授Lyrissa Barnett Lidsky指出,这起案件可能成为AI法律争议的重要范例:“这是一场警示,告诉社会不要轻易把情绪与心理健康交给AI公司。”

她也提醒家长:“生成式AI和社交媒体互动平台不是完全无害的工具。”