Anthropic宣布正在更新消费者条款与隐私政策,未来将允许用户选择是否将聊天内容与程序开发工作阶段的数据,用于训练旗下大型语言模型Claude。公司表示,此举能帮助改进Claude的能力,包括程序设计、分析与推理,同时提升系统对诈骗与滥用等有害行为的防护能力。

Anthropic强调,用户始终保有是否共享数据的决定权。

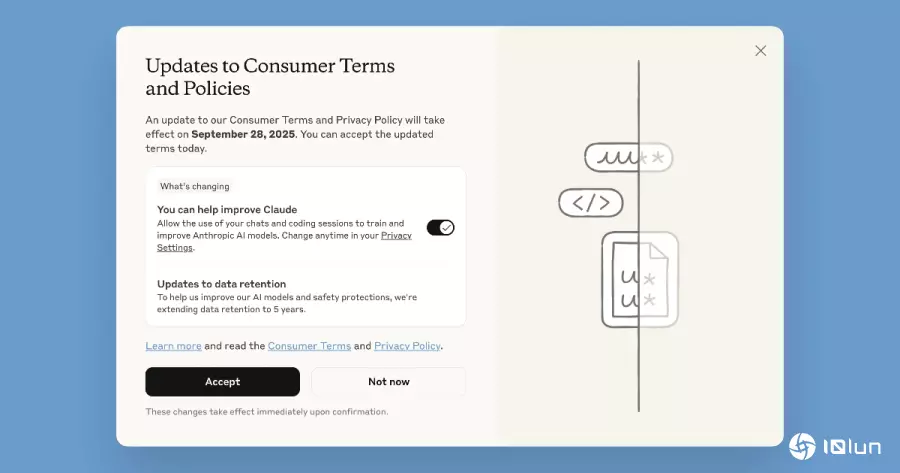

对于新用户,在注册时即可选择是否同意使用聊天记录来改进Claude;现有用户则会在近期看到弹出窗口通知,要求做出选择。如果选择立即同意,新政策会立刻生效,并且只影响新打开或重新打开的聊天与程序开发工作阶段。过去已完成、且没有再互动的对话内容,则不会被纳入模型训练。

若用户当下不想决定,可以在弹窗中点击“稍后再说(not now)”,并在2025年9月28日之前完成设置。超过期未选择者将无法继续使用Claude,直到做出决定为止。未来,用户也能随时通过“设置 → 隐私”页面调整偏好。

新的政策将数据保存期限与是否参与训练挂钩:

若用户允许数据用于模型训练,新或续开的聊天与程序开发工作阶段将被保存长达五年,以便支持模型开发与安全改进。

如果选择不共享数据,则继续维持30天的保存政策。

此外,用户针对Claude回复提交的意见反馈(feedback),同样会在同意的情况下被保存五年。

值得注意的是,即便同意数据用于训练,删除聊天记录后,该对话将不会再被纳入未来的模型训练。

这次的更新只适用于Claude Free、Pro、Max用户,包括使用Claude Code进行程序开发的情况。但如果使用的是以下服务,政策并不适用:

换言之,如果企业或学校是通过商业方案或API服务使用Claude,不会受到这次政策变更的影响。

Anthropic表示,公司会使用多种工具与自动化流程,尽可能过滤或模糊化敏感资讯,并强调“不会将用户数据出售给第三方”。此外,若用户日后改变心意,随时可以在隐私设置中关闭数据共享功能。

需要注意的是,一旦数据已经被纳入进行中的训练或完成的模型,则无法从这些模型中移除,但Anthropic承诺会停止在未来的训练中使用先前已存储的聊天记录。

Anthropic解释,训练大型语言模型需要大量多样化的数据,而来自实际互动的聊天记录,能为模型提供真实的上下文与使用场景。例如,当开发者利用Claude调试程序代码时,这些过程中的数据有助于模型学习,进而在未来更准确地协助其他用户完成相似任务。

公司同时指出,延长数据保存期限也能帮助提升安全性。长期数据能改进内部的滥用检测系统,使其更有效识别诈骗、垃圾消息与有害行为,进一步保障所有用户的使用体验。