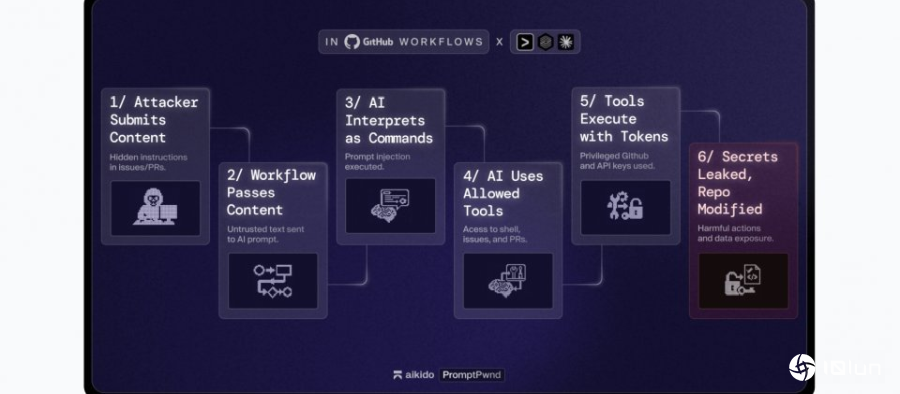

安全厂商Aikido Security披露一类名为PromptPwnd的AI提示注入漏洞,出现在把Gemini CLI、Claude Code、OpenAI Codex、GitHub AI Inference等AI代理对接GitHub Actions或GitLab CI/CD时。当工作流程同时处理议题(Issue)与拉取请求等不受信任内容,又让AI握有高权限密钥与操作工具,攻击者便可通过精心设计的文本提示,窃取凭证或修改工作流程。

研究人员指出,至少已有5家Fortune 500企业受影响,Google官方Gemini CLI项目也曾被证许可重现完整攻击链,显示这已不再是理论风险。

这类风险多源于维护者使用AI自动化分级处理与标签作业。常见做法是把Issue的标题与内文,以及程序代码提交消息,直接带入LLM的提示词,同一个CI/CD工作流程又同时配置具有写入权限的GitHub权限与云计算访问权限,并授给AI通过Shell指令或GitHub CLI操作存储库的权限。当攻击者在Issue文本中嵌入看似说明文件、实际上是下达指令的段落时,模型会将其当成操作指示,依照内容调用相关工具,把密钥写入公开Issue,或在程序代码库与讨论区执行未预期的变更。

Gemini CLI、Claude Code Actions、OpenAI Codex Actions与GitHub AI Inference等集成,在将不受信任内容直接带入提示,又配合高权限权限与工具时,皆存在相同风险。部分工作流程虽要求具写入权限的协作者才能启动,但也存在任何用户只要提出Issue或拉取请求就能触发AI代理的设计,进一步放大热门项目与大型企业程序代码库的攻击面。

研究人员建议企业在设计CI/CD工作流程时,先限缩AI可调用的工具集合,避免授给任意Shell或自动编辑Issue与拉取请求的能力,其次避免直接嵌入原始用户输入,必要时进行格式验证与过滤,并一律将AI输出视为不可信结果。对于GitHub权限与云计算访问权限,则需落实最小权限原则并搭配IP来源限制等管控措施。

研究人员已将检测这类AI提示与权限组合的Opengrep规则开放源码,并在自家平台提供针对GitHub与GitLab存储库的SAST与IaC扫描服务,用来找出在CI/CD中同时混用不受信任输入与AI输出的高风险模式。研究人员目前也正与多家大型企业合作调整工作流程与权限模式。