在当前AI世界狂热地追逐大型语言模型(LLM)时,有一位声音显得格外清醒。他是深度学习的奠基人之一,也是Meta的首席AI科学家 ——Yann LeCun。在2025 NVIDIA GTC大会中,LeCun与NVIDIA首席科学家Bill Dally展开一场对谈。不到三十秒,他便语出惊人:“我已经对LLM不感兴趣了。”

这句话并不是单纯的挑衅,而是一场思想上的转向。他的目光,早已越过了语言模型的边界,投向更深层的智慧挑战。他看见了今天AI的盲点,也为它描绘了一条前所未见的路。

在这场谈话中,LeCun表达了一种几乎与主流意见相左的观点。他认为当前LLM的发展已经进入工程优化的阶段,重点在于“多一点数据、多一点算力”来让模型更稳定、更具商业价值。

“这些是产品经理的事,对我来说不再有趣了。”他说。

他不否认LLM所创造的语言奇迹,但在他看来,那并不是智能的终点,而仅是语言模仿的技术。真正的智慧,不该只是生成文本,而是理解这个世界、记住以往经验、推理出未来的可能,并能根据目标规划行动。

这一切,都不是现在的LLM所能做到的。

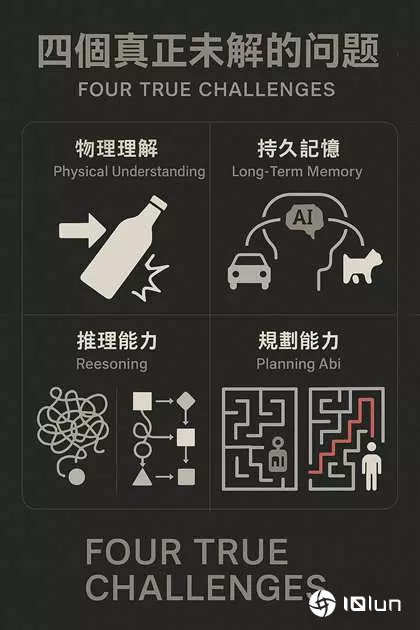

谈到AI未来真正的挑战,LeCun清楚地指出了四个他认为至关重要、但目前尚未有令人满意解答的领域。

第一是对物理世界的理解。他举了一个极简的例子:当人看到一个瓶子,知道推它会滑,敲它会弹,这些都是我们从小累积的世界模型。但今天的AI,无论是从图片、视频还是文本中,都无法真正掌握这些“常识”。

第二个挑战是持久记忆。大多数AI系统处理输入时是一次性的:输入 → 推理 → 输出。它不会记得你上一秒说了什么,更无法累积对世界的长期观察与认知。而人类的记忆,正是推理与学习的基础。

第三,则是最根本也最具哲学意味的问题:推理。LeCun对如今所谓“agentic AI”的批评颇为严厉。他认为让模型生成一堆答案,再从中选出最可能正确者,根本不是推理,而是暴力试错。他说这种方法就像“乱写程序然后看哪个跑得动”,低效而粗糙。

第四个挑战则是规划能力。真正的智慧不只是对当下做出反应,更能思考未来。他形容:“如果AI能够在内部模拟一个世界,然后根据某个假设行动去预测未来的结果,那它就能计划完成目标的最佳路径。”而这,才是人类做决策的真正方式。

对于解决这些挑战,LeCun并非空口语白话。他和团队已经在设计一套崭新的AI架构,名为JAPA(Joint Embedding Predictive Architecture)。它不是语言生成器,不模仿人类对话,而是一套可以在抽象空间中思考与预测的系统。

“当你在脑海中想象一颗立方体旋转,你不是在脑海中拼字词,而是在操作一种抽象模型。”LeCun如此比喻。他希望AI也能具备这样的能力 —— 在一个抽象表示空间(latent space)中,理解世界的结构,模拟行动的后果,进而推理与规划。

这是一种对如今LLM的彻底颠覆。不是token的堆栈,不是语言的预测,而是认知与世界模型的构建。

除了技术的革新,LeCun也毫不掩饰他对“开源”与“多样性”的支持。他强调,真正的AI不会只诞生在硅谷的几家公司手中。

“未来的智慧助理,不能只说英文,也不能只有一种文化观。它们要能理解全世界所有语言、文化、价值观与偏好,”他说,“我们需要一个像新闻媒体一样多样的AI生态。”

他将LLaMA模型与PyTorch的开放精神视为未来的希望,也认为foundation models应该走向全球分布式训练与社交媒体式贡献,让各地区能以保有数据主权的方式,共建全球智能基础。

当对话接近尾声,LeCun又补上一句:“未来的人工智能,不会是一个瞬间、一家公司、一个模型的成就,而是整个人类社交媒体长时间积累的成果。”

他认为,这个过程将需要开放的研究、全球的合作、与更便宜、更高效的硬件(然后开玩笑地说:“NVIDIA,你们该降价了。”)。

如果说LLM是当今AI的盛世,那么LeCun心中的未来,是一场真正对人类智能本质的回归。他不做炒作,不讲流行语,只是默默地,用他的方式,让AI回到一个根本的问题:它到底懂不懂这个世界?