NVIDIA于AI Infra Summit 2025(人工智能基础设施高峰会)带来最新MLPerf Inference基准测试成绩,使用Blackwell GPU搭配分离运算技术,能在不变动硬件的前提下带来近50%性能增益。

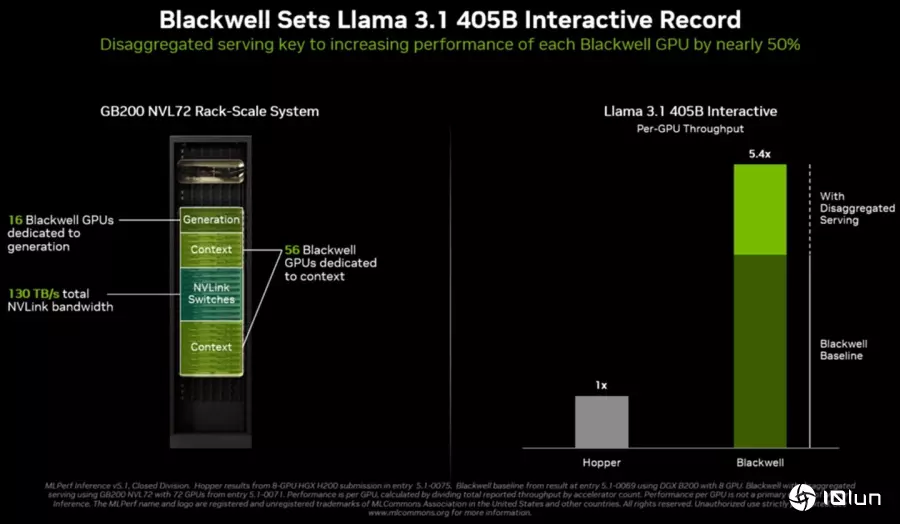

笔者在前文提到分离运算(Disaggregated Serving)的概念,NVIDIA除了将它利用在下代的Rubin CPX GPU之外,也将其导入Blackwell架构GPU,将现有的GB200 NVL 72拆分为2个工作群组,分工合作发挥1加1大于2的性能增益。

在Llama 3.1 405B Interactive测试中,GB200 NVL 72的72组Blackwell GPU被拆分为56组负责第1阶段的前后文分析与预填写(Context/Prefill),剩余的16组负责第2阶段则为生成与解码(Generation/Decode),相较于未分组的运算方式,能够提高近50%的性能增益。

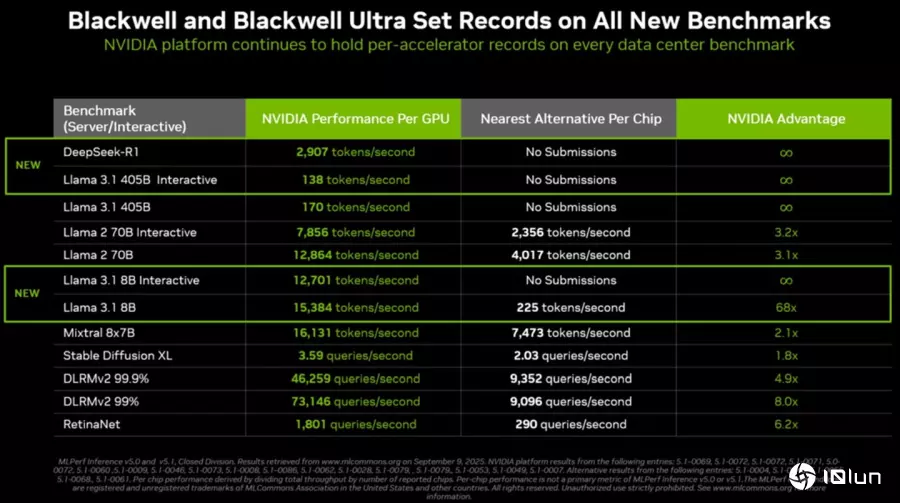

在新提交的MLPerf Inference基准测试成绩中,单组Blackwell GPU执行Llama 3.1 8B的性能达每秒15,384字词,表现最佳的竞争对手单芯片性能仅每秒255字词,彼此相差68倍,另外3项测试则是没有任何竞争对手提交测试成绩。

在Llama 3.1 405B Interactive测试中,将GB200 NVL 72拆分为2个工作群组,能够提高近50%的性能增益,让整体性能达到Hopper架构GPU的5.4倍。

在Llama 3.1 405B Interactive测试中,将GB200 NVL 72拆分为2个工作群组,能够提高近50%的性能增益,让整体性能达到Hopper架构GPU的5.4倍。

在新提交的成绩中,单组Blackwell GPU执行Llama 3.1 8B的性能达每秒15,384字词,优于表现最佳的竞争对手68倍。

在新提交的成绩中,单组Blackwell GPU执行Llama 3.1 8B的性能达每秒15,384字词,优于表现最佳的竞争对手68倍。

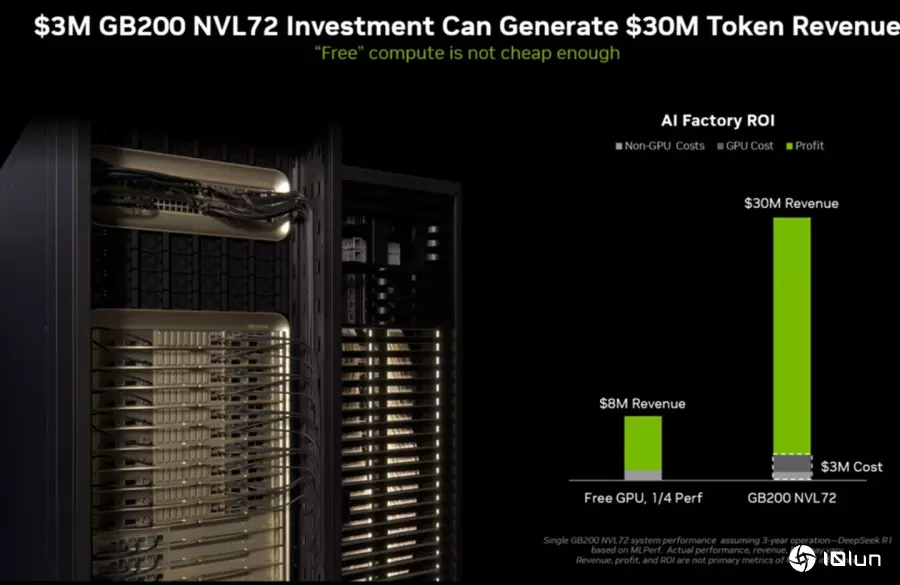

NVIDIA表示投资300万元构建GB200 NVL72服务器,所产生的字词(Token)将可带来3000万元的营收。

NVIDIA表示投资300万元构建GB200 NVL72服务器,所产生的字词(Token)将可带来3000万元的营收。

Blackwell、Blackwell Ultra都已经进入完全生产状态,明年将会由Vera CPU与Rubin GPU接替市场。

Blackwell、Blackwell Ultra都已经进入完全生产状态,明年将会由Vera CPU与Rubin GPU接替市场。

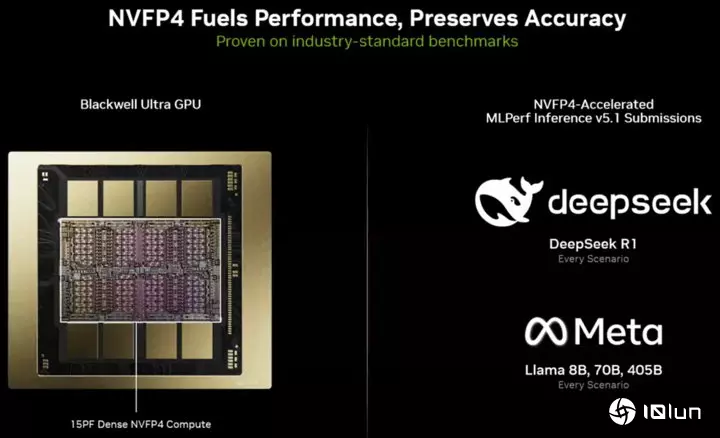

Blackwell Ultra GPU支持NVFP4数据类型,能够发挥15PFLOPS的理论运算性能。

Blackwell Ultra GPU支持NVFP4数据类型,能够发挥15PFLOPS的理论运算性能。

AI Infra Summit 2025于2025年9月9日至11日在美国加州圣克拉拉会议中心举行,更多详细资讯可以参考官方网站。