AI明明是学习无数数据的巨兽,却常让人觉得“越来越像一个乖学生”——无论问它讲笑话、写故事或聊哲学,答案都像是从同一个模板里复制出来的。最新研究指出,大语言模型的“模式坍塌”并非算法错,而是人类训练数据中隐藏的“典型性偏差”所致。研究团队提出一种新方法,让AI在回答时同时产出多个结果与机率,成功唤回模型的创造力,并预示未来AI训练的新方向。

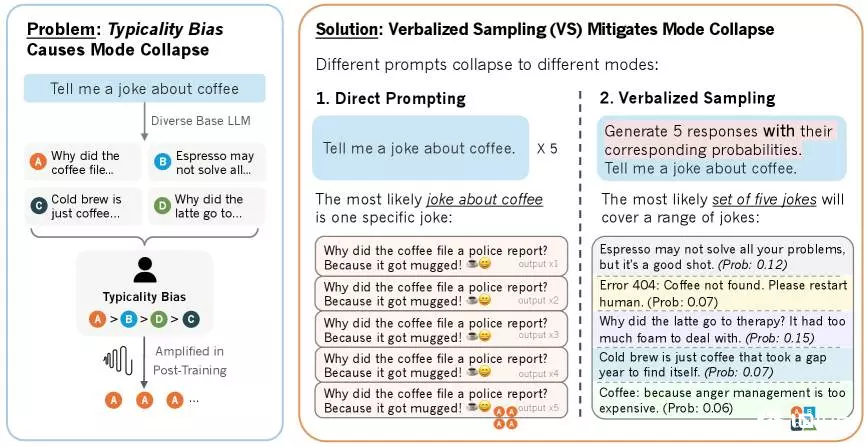

在大型语言模型(LLM)调校阶段,经常会出现“模式崩塌”(mode collapse)现象:模型倾向生成重复、守旧或缺乏创意的回应。传统上,这种情况多被归因于算法设计(如RLHF强化学习或顺序优化)所造成。但来自美国斯坦福大学(Stanford University)与东北大学(Northeastern University)等机构的研究团队指出,导致模式崩塌的根本原因之一其实是“人类偏好数据”中的典型性偏差(typicality bias)。他们进一步提出一种称为“口述采样”(Verbalized Sampling, VS)的提示设计策略,以低成本且无需重新训练模型,即可提升模型回应的多样性。

研究者指出,在人类偏好评分数据集中,标注者往往偏好熟悉且典型的文本回应,而不是罕见或风格独特的选项。这种偏好在模型训练中被强化,使得模型在生成阶段也倾向“安全、守旧”的答案,从而降低了创意与多样性。为了对抗这个趋势,研究团队将焦点从只看算法,转向“数据层面偏误”并设计了解决策略。

口述采样是一种提示(prompting)策略,用户在向模型提问时,不仅要求模型生成多个候选回应,还要模型将每个候选回应所对应的“机率”以文本形式输出。举例来说,可以这么下提示词:

“请产生5个关于“咖啡”的笑话,并为每个笑话标示其机率(model self‑assigned probability)。”

如此一来,模型被要求从内部的分布中采样,而非仅输出单一“最高机率”回应。这样的设计有助于唤醒模型预训练阶段所蕴含的多样性潜力。

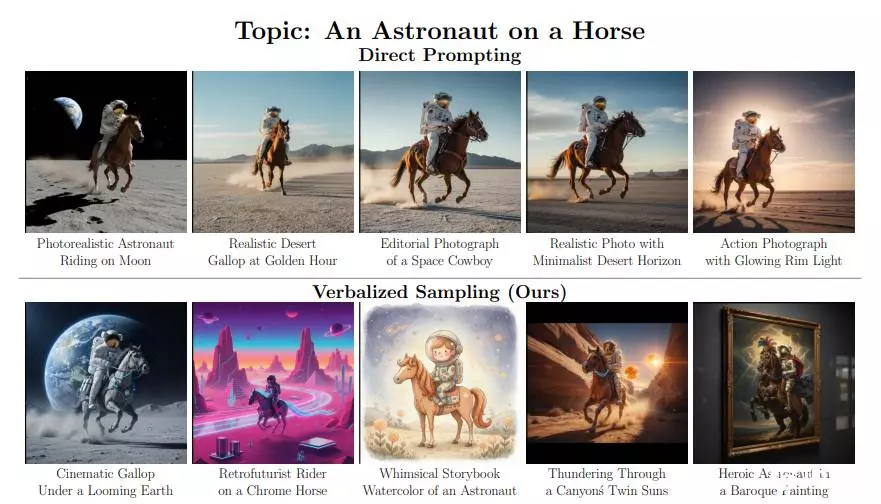

在创意写作(诗歌、故事、笑话)任务中,使用口述采样后,多样性提升约1.6至2.1倍。

在开放式问答(open‑ended QA)或枚举型任务中,模型覆盖的答案种类大幅增加,而准确性与安全性并未受损。

在对话模拟、合成数据生成等任务中也展现出效益,更强的模型版本,其成效也越明显。

首先,这个策略不需要对模型进行额外再训练或调校,仅通过改变提示设计即能改善多样性,对实务应用门槛低。其次,若模型在商业产品中被用于创意生成、对话系统或合成数据,那么提升回应多样性意味着更丰富、更具人性化的互动体验。最后,它也突显了对“数据偏误”(而不仅仅是算法)进行反思的重要性。

在产品或平台开发中,若使用大型语言模型生成内容(如文案、脚本、角色对话、测试数据等),可考虑以下做法:

将提示从“请生成1个回应”转为“请生成N个回应,并标示每个回应的机率”。

解析模型所标示的机率,选择机率较低但创意较高的回应以增加新意。

将“多样性”纳入指标评估,而非只关注“最有可能的”一种回应。

若模型回应过于保守、重复或缺乏变化,特别适合使用此策略。

该研究集中于文本生成任务,多样性的提升是否会在所有任务类型(如高度精确的技术回应或严格规格问答)中同样有效仍待进一步验证。另外,虽然无需再训练模型,但仍需要用户端解析与使用模型所输出的机率,可能对工程集成提出一定要求。未来研究可探讨这种提示策略对其他模态(如形象、代码生成)或更大规模模型的作用。