随着生成式AI的爆炸性增长,内存不再仅是辅助组件,而是人工智能智能的起点与关键驱动者。因此,在2025 Semicon Taiwan的内存论坛上,难得的全球三大内存大厂SK海力士、三星和美光同台参与活动,并通过主题演讲诉说当前重新定义内存在AI时代中角色的必要性,以共同面对AI基础设施在性能、功耗和扩展性方面的严峻挑战,并通过创新与合作,塑造AI的未来。

SK海力士借全堆栈内存引领AI性能与效率SK海力士副总裁崔俊龙强调,AI市场正以惊人的速度发展,数十甚至数百种AI模型正扩展到成千上万的下游应用中。这对AI基础设施提出了跨越性能、可扩展性和功耗效率的庞大需求。内存,特别是高带宽内存 (HBM),已成为AI机会的核心。SK海力士正从单纯的内存供应商转变为提供“全堆栈内存”解决方案,并以此愿景引领业界。

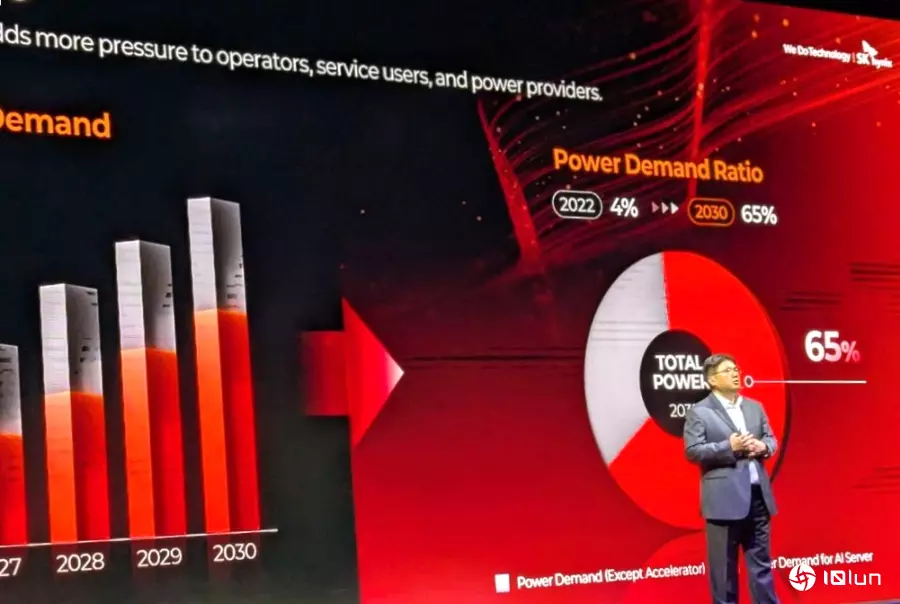

另外,AI基础设施面临带宽、功耗、热密度和实体空间等关键限制。预计到2030年,数据中心所消耗的电力将比2023年增加三到六倍,其中AI工作负载将占总电力需求的65%。功耗已成为AI产业最关键的考量因素。崔俊龙指出,HBM在单一AI机架中的功耗占比正从12%增加到未来的18%或更高,而HBM功耗效率提升10%,可使整个机架的总功耗节省10%。内存带宽更是AI训练和推论的瓶颈。

崔俊龙强调,为应对这些挑战,SK海力士持续推动技术边界。其最新的HBM升级版本相较于HBM3,带宽提升超过200%,功耗效率提升高达40%。SK海力士更率先开发出HBM3E,其容量达36GB,带宽超过2TB/s,树立了新的行业标杆。未来,HBM将不再仅是内存,而是会嵌入新功能和处理能力,从被动变为主动式智能的一部分,为每个客户和AI芯片量身定制具备专用功能的内存。

最后,SK海力士明确表示,台湾拥有独特的“横向集成生态系统”,涵盖芯片代工、封装、测试到系统集成,是唯一能提供全阶段AI平台的区域。SK海力士将运用其HBM的领先地位,为台湾的AI生态系统提供所需的内存,共同创建AI基础设施的未来。他们强调将与台湾AI的横向集成站在一起。

三星定制化解决方案与效率创新应对AI挑战三星内存产品规划副总裁Jangseok Choi在演讲中表示,AI模型的计算需求在过去15年间每年增长4.7倍,但计算性能以及内存容量和带宽的增长速度却远不及此,导致了严重的瓶颈。OpenAI图像生成功能引起的GPU过热问题,便是AI基础设施不足的写照。此外,到2030年,全球数据中心的电力消耗可能比去年翻倍,若AI采用率高于预期,甚至可能更高。

为解决AI时代的四大挑战 (性能、基础设施、功耗和工作负载管理),三星提出了“定制化HBM解决方案”(Bespoke HBM)。他们可以根据客户的具体需求调整HBM的特性和功能,无论是追求最大带宽、成本效益还是功耗效率。三星作为唯一能够提供内存、逻辑、芯片代工和先进封装等全面内部服务的公司,具备独特的价值主张。

在提升效率方面,Jangseok Choi表示,三星正在开发PIM(处理器内存) 技术,通过将某些任务从GPU卸载,显著降低功耗并提升系整理体性能。例如,LPDDR6 PIM的性能比传统解决方案高3.6倍,能耗却减半。此外,针对生成式AI庞大的数据需求,三星推出新的AI分层存储解决方案,包括性能层、存储层和容量层,并开发了针对LPDDR内存的SoC-M2,以实现数据中心的扩展和效率优化。在未来,三星将推动HBM封装从热压缩接合转向混合铜接合,实现更高的堆栈层数、更佳的散热和更高的信号完整性。

演讲最后,Jangseok Choi明确表示,要感谢台湾半导体产业提供的宝贵支持,这对三星实现其目前的领先地位至关重要。面对日益复杂的产业挑战,三星强调与台湾产业的持续合作对于开创创新解决方案和推动技术进步是不可或缺的。他们希望与台湾共同建设更好的未来。

美光内存创新与3D DRAM的突破美光副总裁Nirmal Ramamurthy指出,AI正在带来巨大的经济价值和产业变革,但AI模型的复杂度不断提升,需要惊人的内存容量,预计不久的将来参数将达到数万亿。目前,计算性能的增长速度(每两年1.6倍)快于内存性能,导致两者之间的差距不断扩大,这要求内存必须以更快更好的速度扩展。能源效率是AI可持续发展的另一个关键限制,预计到2030年,数据中心将占美国能源需求的10%,其中大部分来自AI。

Nirmal Ramamurthy强调,新的AI工作负载促使服务器架构演变,专用计算刀锋服务器中的GPU与HBM紧密耦合,而LPDDR等内存也通过高性能互联与CPU相连。美光强调,AI的成功依赖于一个全面的内存阶层,包括高带宽内存 (HBM)、平衡主内存(如LPDDR、DDR等)以及可扩展的大容量内存和AI优化存储。美光提供了广泛的内存产品组合,以满足AI计算系统的多样化需求。

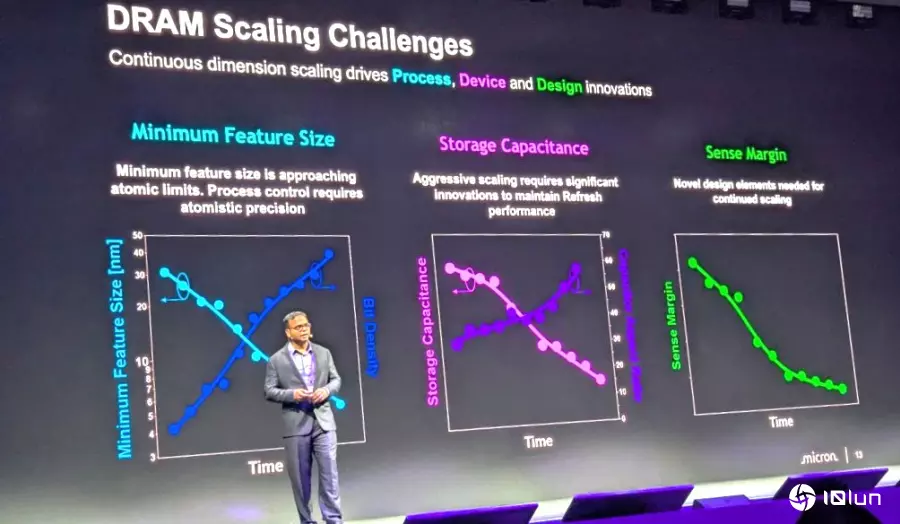

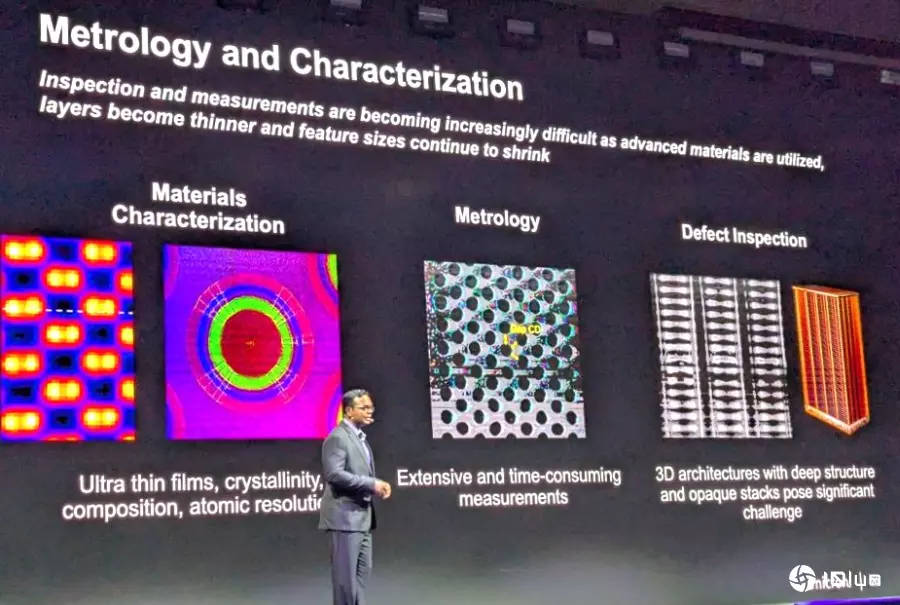

Nirmal Ramamurthy进一步指出,内存技术的发展必须优化性能、容量和功耗,以应对从数据中心到边缘AI设备的各种需求。HBM的成功依赖颠覆性的制程、设计创新和先进封装架构。DRAM核心面临着微缩至原子级限制、电容长宽比增加以及传感裕度缩小等技术挑战。

为克服这些限制,美光预期未来DRAM将走向类似于3D NAND的“3D DRAM”结构,通过垂直堆栈来增加单元体积。这项技术需要高性能CMOS、复杂的芯片接合以及创新的制程设备。此外,美光也在探索1T-1C铁电内存等新兴内存,因其接近DRAM的性能和成本效益,有望在扩展内存中发挥作用。美光也积极利用AI和建模来加速自身的技术开发流程。

(首图来源:科技新报摄)