面对各种生成式AI的应用日益普及,固然带来便利,但越来越多人更关注AI治理可能面临的风险。

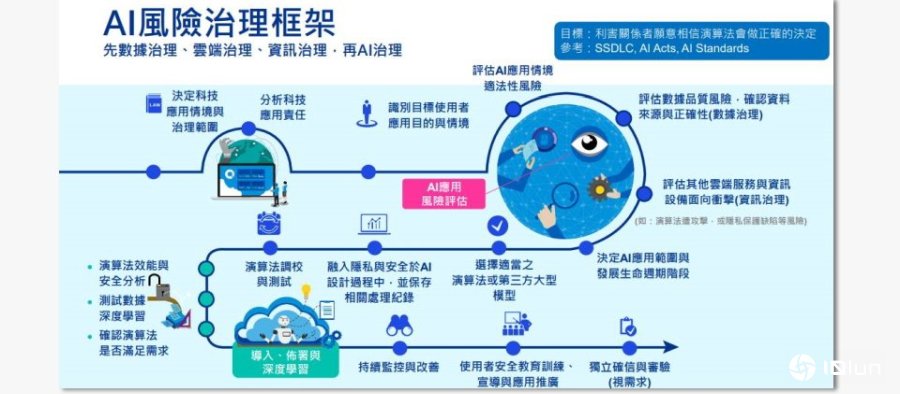

台湾KPMG安侯企管顾问执行副宏观经济理林大馗表示,进一步参考SSDLC(安全的软件开发生命周期)、各国家的AI法案和各种AI标准,我们可以发现,如果要落实AI的风险治理,可以先从落实数据治理、云计算治理、资讯治理,接下来,才能再进一步做到AI治理,继而推动AI治理最终目的:利害关系者都愿意相信算法会做正确的决定。

而他认为,不论企业或是组织想要做到AI治理,都应该创建一个可供参考的框架,进而提升AI的信任度,并且做到AI的风险评估,以及AI的治理,这些都会是整个人类社会必须共同面对的重大挑战。

参考安全的软件开发生命周期、各国AI法案和多种AI标准后,KPMG认为,企业与组织若欲落实AI的风险治理,可以先从数据治理、云计算治理、资讯治理之后,再来做到AI治理,目的就是要做到利害关系者,愿意相信算法会做正确的决定。图片来源/KPMG

先做到数据、云计算、资讯的治理,才能做到AI治理

“慎始!”林大馗表示,所有的AI应用最重要的,就是刚开始要决定“范围”,包括:科技应用场景与治理范围。

然后做到“分析”科技应用责任后,再“识别”目标用户应用的目的与场景,下一步,便可以“评估”AI应用场景与适法性风险。

后续须做到“数据治理”:评估数据品质风险,确认数据源与正确,也须对相关AI应用进行“AI风险评估”;接着进行“资讯治理”:评估其他云计算服务与资讯设备面向冲击,例如,所运用的算法是否可能遭受其他攻击,或是隐私保护缺陷等风险。

接着,进入“决定AI应用范围与发展生命周期阶段”,选择算法或第三方大型模型,并在AI设计过程“融入隐私与安全”,同时做到保存相关处理记录,接下来还要进行“算法调校与测试”:不仅要做到算法性能与安全分析,还要测试数据深度学习,并且要确认算法是否能够满足需求。

最后,在导入、部署与深度学习后,还是要做到“持续监控”与改善,并对用户进行安全“教育训练”、宣导与应用推广,还可以视需求,进行“独立确信与审验”。

图片来源/KPMG

AI成黑客诈骗、伪冒身份利器,“眼见为凭”将不可信

对于企业和组织而言,又该如何架构AI安全防护呢?林大馗说,包括强化基础网络架构韧性,以及打造多层次零信任架构(Zero Trust),这些都是可行的方法。

他进一步指出,目前AI已经可以做到的方式,包括:使用AI来训练防御系统,识别和防御AI攻击;也可以构建多层次网络安全措施,提高防御AI攻击的有效性。

另外,也要做到定期更新安全软件和修补漏洞,减少AI攻击的成功率;提高员工的安全意识,可以帮助员工识别和防御AI攻击。

对此,林大馗提出生成式AI遭网络犯罪集团滥用,提高虚拟犯罪效率的例子。

因为这些隐藏在网络背后的虚拟绑匪,已经能够做到利用语音复制、SIM卡劫持、ChatGPT以及社交媒体网络分析与倾向(SNAP)模型,寻找最有利可图的目标并执行诈骗。

又或者这些网络犯罪份子都开始利用AI工具,创建层层自动化搜集资讯、发掘鱼叉式网络捕鲸,或以爱情诈骗手法攻击高知名度受害者。他坦言,现在蓬勃发展的生成式AI,已经成为军火库,黑客能借此发动各种网络攻击、入侵,甚至,可以成功达到诈骗目的。

另外,也有黑客成功利用深伪技术(Deepfake)伪冒身份验证。

他表示,现在的AI深伪变脸技术,已经可以制造出逼真的虚假图片和声音,模拟度极高,加上AI变脸软件还内置许多来自不同人种的脸部图片,甚至联名人、明星照片也有,可以让用户自由选择性别及种族。

他指出,这些遭到伪冒的深伪图片,就算从正面观看,都可以做到以假乱真,很容易让人们误判,以为伪冒者是被害者本人、检警或名人。

当生成式AI做到以假乱真,林大馗指出,企业对网络基础架构也会有纵深防御要求,从企业组织内部的用户开始,一直到要面对组织外的风险,在整个工作环境的范围之内,都必须部署各种基础的安全防护设备,目的就是要做到构建零信任网络架构,并且能够即时进行漏洞更新修补。

林大馗表示,单靠基础的安全防护设备,并不足以对抗这些生成式AI对企业、组织甚至是个人带来的安全风险。

所以,我们还必须做到高端防御强化的要求,例如在公开视频添加专属散列值,或是安全凭证;或善用现阶段机会,趁深伪技术存在未能完整学习受复制对象侧面的技术缺陷,可要求以生物认证方式来识别对象,左右转头90度并维持一小段时间,因为如果是利用深伪技术所伪造的视频,可能会产生人脸闪烁的情况。

以其他做法而言,我们可扩大运用“MFA多因素认证”,要求用户必须通过两种以上的身份认证机制,之后才能取得授权。

另外,可以采用零信任“永不信任、总是验证”的资讯架构,包含以每个连接为基础,评估每个人信息源请求者的访问要求等机制,避免使用一次性验证后,就可以长时间与完全取用所有服务的传统做法。

甚至,我们要能够让用户创建“眼见不为凭”的警觉,让一般人们能够充分理解到:过去习惯的“有图有真相”的心态,已经到了必须改变的时候,不然,这就可能沦为一种“看片都上当”的习性。

为了架构足以应对AI安全风险,台湾KPMG安侯企管顾问执行副宏观经济理林大馗表示,企业必须打造基础网络架构的韧性,从内部用户到面对组织外的环境,都必须构建具备零信任的网络纵深防御,并做到即时漏洞更新。图片来源/KPMG

利用3种方式提升AI方案的可信任度

为了成功推行人工智能(AI),组织与社会必须能够相信AI会做出正确的决策,而且AI不会做出错误的决定,KPMG目前提出名为“人工智能风险控制与管理”的框架。

这个框架包含3种促进人工智能解决方案取得信任的方法,希望通过提升算法的信任,让“生成式AI”可以提升到“生产力AI”。

林大馗指出,这些方式分成:(1)与其他决策方法∕模型来做结果比对;(2)介入理解与验证人工智能模型;以及(3)于可控的环境中发展人工智能解决方案。

他也进一步解释,举例说明3种方式可能面临的结果。

若以(1)与其他决策方法∕模型来比对结果,可能面临下列几种情形,例如:其他可靠的决策方法或许不存在;更换模型或开发替代方案,并非总是可行的;如果有其他决策来源,为何还需要发展人工智能解决方案?

若采用(2)介入理解与验证人工智能模型的方法,也可能面对模型或许过于复杂,甚至于人类无法进行解释或理解。因为模型本身使用深度神经网络(Deep Neural Networks),众所皆知,这项技术的运行原理很难解释。

如果是采用(3)在可控的环境中发展人工智能解决方案,同样会面临挑战。例如,于安全的环境中,技术人员使用严谨的方法论,并不能保证品质结果;在数据科学领域中,使用较严谨的方法,与AI领域常用的敏捷与较前瞻的方法,可能有所违背。

林大馗坦言,无论用何种方式提高AI解决方案的信任度,但实际上,都有其限制。

对此,KPMG发展出一套“人工智能风险控制与管理的治理框架”,期盼协助组织与企业利用上述三种方法,定义出最优良的控制措施组合。

为了成功推行人工智能,组织与社会必须能相信它会做出正确的决策,并且不做出错误的决定。KPMG为此提出“人工智能风险控制与管理”框架,期盼通过三种方法的运用,促使人工智能解决方案的发展与应用能够得到更大的信任。图片来源/KPMG

落实AI安全整备度之余,也必须培养AI治理团队

面对AI甚至是生成式AI的日益发展,组织、企业甚至是个人是否都已经做好足够准备?面对AI时代的来临,又该进行何种前瞻的安全布局呢?

林大馗认为,所有的组织和企业应该要做到AI安全整备度分析,以及培养AI治理团队智识与人才地图。

在AI安全整备度分析方面,我们可以从五个方面来看,包括:人才投入、研发与市场经营、生态链合作、基础建设、法规。

先从人才投入的面向来看,企业与组织要能够做到外部机构的AI安全协同合作、AI安全开发,以及使用AI解决方案的宣导活动,以及制定AI安全性的指引与实务守则。

而从研发与市场经营的面向来看,企业须提高对AI安全能力的必要资源投入、制定国家对AI发展的限制与安全规范,落实相关规范与监控机制。

针对生态链合作的面向,包括AI的API管理、数据品质、数据交换安全、开放数据(Open-Data)治理等,需要处理的内容包括:

● AI事件通报与处理

● AI威胁、漏洞和安全控制情报信息

● 如何和外部机构合作,有效处理AI相关事件

● 定义∕开发∕使用特定的网络安全度量或指标

● 监控AI系统生命周期中的安全水平

● 要求AI利益相关者进行动态风险评估

● 对违反数据和模型完整性进行制裁

关于基础建设面向中,像是数据、算法、通信等,都包含在内,要处理的对象,则包括:监控开发人员、关键基础设施厂商等AI利害关系者,都要采取合宜的安全控制措施,以及定义AI利害关系者的安全控制措施。

最后的法规面向,涵盖AI道德规范、AI标准、AI与数据治理相关法规,例如欧盟人工智能法案(AI Act),以及欧盟个人信息法GDPR等。因此,我们要处理的内容,包括:法规盘点与风险识别;监控AI数据集的完整性和品质;并创建认证或评估机制,以评估AI系统安全。

要能够推广和应用AI,企业在AI治理团队与人才地图中,除了“咏唱师”,还需要“调音师”。

林大馗表示,在人才投入面向,企业成立当责AI治理委员会、制定AI策略与延聘治理顾问,并落实AI安全性的指引与实务守则。

如果是在研发与市场经营面向上,企业与组织除了要制定AI策略,以及延聘治理顾问,也必需要设立AI安全审核师和AI生命周期安全小组。

至于生态链合作面向上,要成立安全事件管理小组,成立针对AI威胁、漏洞和安全情报信息的管理小组,以及AI生命周期安全小组,对于AI生态链与委外厂商,也必须成立相关的管理小组。

至于基础建设面向上,企业除了要有AI策略与治理顾问,也必需要有AI生态链与委外厂商的管理小组,以及网络安全小组。

最后在法规面向上,企业则要有数据品质管理的管理小组、数据法规专家小组,以及创建认证或评估机制,以评估AI系统安全性。

想开发安全可信的AI应用,可依据WEF的指引设计

林大馗认为,对于设计各种AI产品或服务,我们可以参考世界经济论坛(WEF)在2022年3月发布的指引《Artificial Intelligence for Children》,其内容可以统称为FIRST指引,其中包括了五大项目,分别是:Fair(公正)、Inclusive(包容)、Responsible(负责)、Safe(安全),以及Transparent(透明)。

“公正”是从公司文化和流程层面,解决人们如何开发AI模型,以及AI模型在使用中,所受到道德方面的影响与偏见问题。

“包容”则是留意到AI模型如何与来自不同文化,以及不同能力的用户公平互动,所以,在产品测试的过程中,需要包括不同类型的用户。

所谓的“负责”,主要是因为AI相关产品常反映当下最新的学习科学和科技应用范例,毕竟,最终发展AI,就是要做到如何实现健康的认知、社交、情感或身体发展,并且负起相关的责任。

关于“安全”这一项要求,主要是因为AI技术必须做到保护用户和购买者得数据,因此,应用AI提供产品或服务的公司,应该要披露其如何收集和使用数据及如何保护数据与用户隐私,也允许用户随时选择退出,并删除他们的数据。

“透明”则是要求提供AI产品或服务的公司,必需要能够以非技术术语向买家和用户解释为什么使用AI、AI如何工作以及如何解释AI的决策过程;使用AI的公司也必须承认AI有其局限性和潜在风险,并开放监督和审核。

林大馗指出,所有组织或企业使用AI的初衷,都是为了提供更好的产品和服务,若能参考这份简称为FIRST的AI应用指引,不仅可以提供保护,降低AI对孩童造成的可能风险,也是应用AI时,应该要关注的重点。