在2025年OCP Global Summit上,Meta副总裁Dan Rabinovitsj表示,随着人工智能(AI)算法与大型语言模型(LLM)快速演进,Meta的基础设施正全面升级,从单一GPU集群扩展至跨多地区的超级数据中心,以支撑庞大的AI训练需求。他指出,AI的扩展需求远超过原本的想象,也将推动整个基础设施从设计、连接到能源配置需重新调整。

从单一集群到跨区域超级运算

Rabinovitsj表示,随着AI模型规模与运算量急剧增长,Meta已从早期的小型GPU集群,逐步发展出能横跨整座数据中心的训练架构,并开始尝试连接多个地区的数据中心,打造“跨区域AI集群”。

他坦言,这样的规模化不只是硬件升级,更涉及到网络互联、散热与能源管理等全方位挑战,也象征AI训练正迈向真正的“全球级规模”。

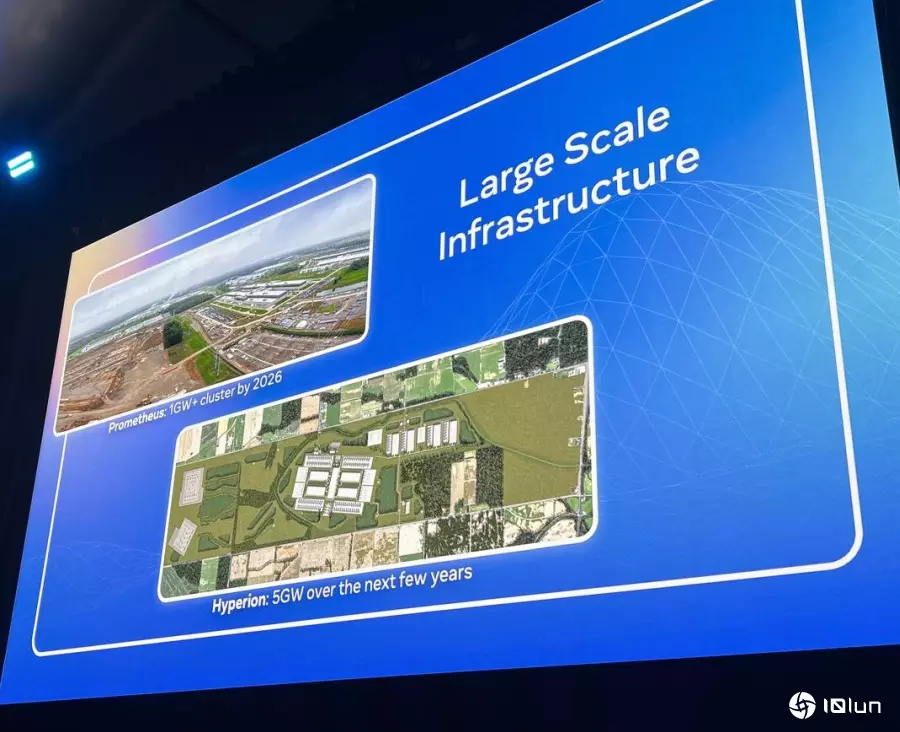

Meta数据中心New Albany与Hyperion

目前Meta正同步建设两座超大型数据中心:位于俄亥俄州New Albany的Prometheus集群已正式投入运行,总功率超过1 GW;另一座位于路易斯安那州Richland Parish的Hyperion中心则规模达5 GW,为全球最大单一AI数据中心之一。

Rabinovitsj形容:“如果你从曼哈顿下城14街一路走到中央公园北端110街,走路大概需要三小时的距离,大约就是Hyperion的实际规模。”若以台湾为例,长度甚至比从内湖科学园区走到台北101还远。这两座数据中心将支撑未来时代的Llama模型与多区域AI训练集群,象征Meta正正式迈入跨区域的超级运算时代。

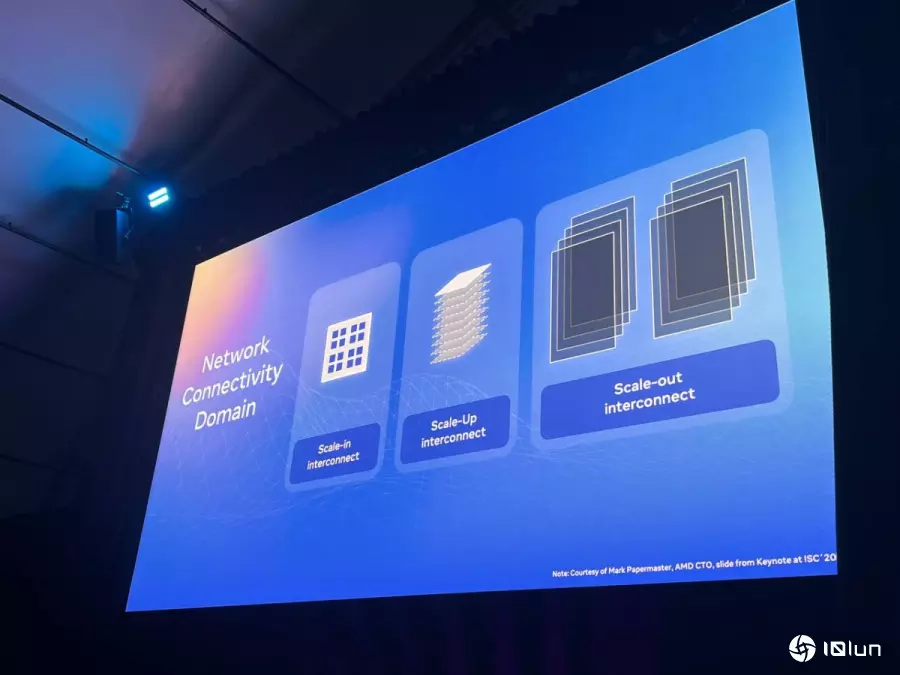

Scale-In、Scale-Up、Scale-Out架构支撑超大规模AI

随着AI模型参数量持续倍增,Meta采用三层级扩展架构──Scale-In(芯片内互联)、Scale-Up(集群内互联)、Scale-Out(跨区域互联)。

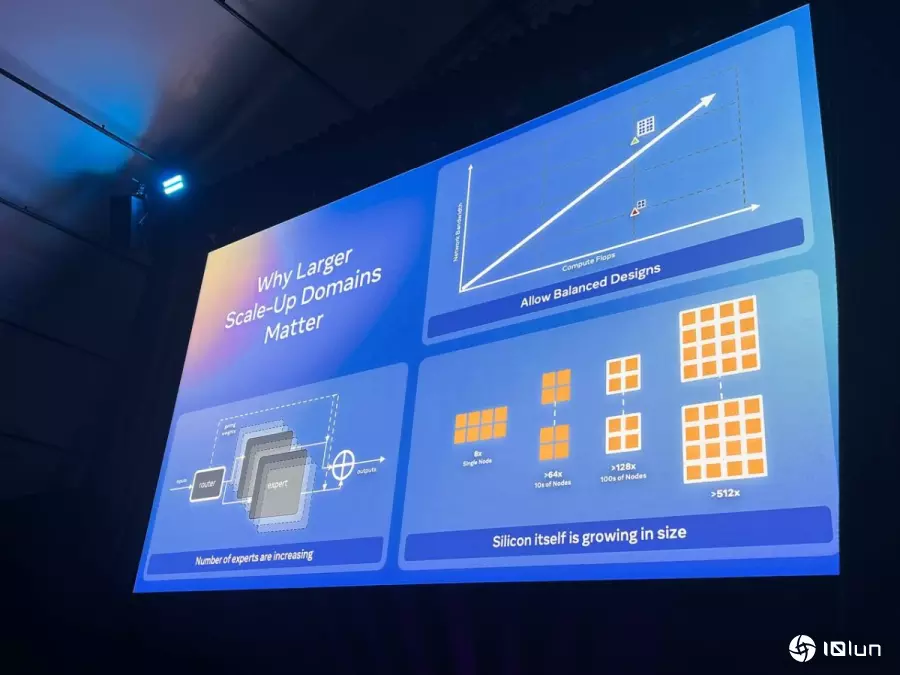

其中,Scale-Up对AI性能愈发关键。Rabinovitsj解释,随着芯片的运算密度与FLOPS急剧提升,若无法同时扩大网络与内存带宽,就无法充分发挥运算能力;而更大的Scale-Up域名正能在同一高速互联环境中平衡这三者的性能。

他进一步指出,Mixture-of-Experts(混合专家模型) 的兴起也是关键因素。此类模型由上百个专家节点(experts) 所组成,每次运算仅激活部分节点进行动态路由,因此需要极低延迟的通信环境。

“这些专家必须共存在同一个Scale-Up域名中,才能维持训练效率与稳定度”。

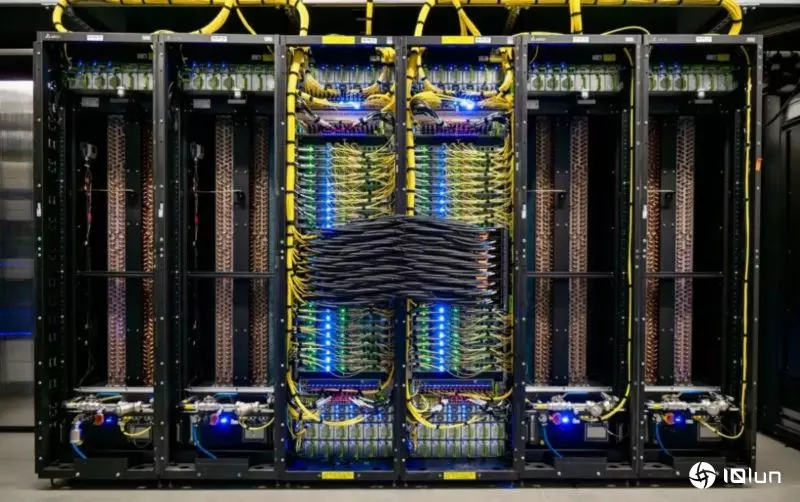

为了支撑这样的高密度运算与低延迟互联需求,硬件层面的变革也势在必行。“我们不得不打造越来越大的机架(rack),这已是整个产业的趋势,”Rabinovitsj表示。

然而,这种“疯狂规模”的扩展也带来前所未有的挑战。Rabinovitsj坦言,大型机架的设计与运维极为困难,仅移动一座机架的重量就相当于“一头非洲象”。随着功耗与热密度攀升,液冷技术已成为不可逆的主流方向。

他指出,未来的关键将是Optical Disaggregation:以光互联取代传统铜线,让电力分配更灵活、能有效降低能源浪费,同时提升数据中心电力使用效率(PUE)。这项转变不仅能缓解电力压力,也将为AI训练集群打开更高密度与更长距离的互联设计空间。

电力与人才需求同步飙升,产业面临三大压力随着基础设施规模持续放大,Rabinovitsj指出,整个产业正同时面临三大压力:电力供应不足、工程人才短缺与制造产量不足。他透露,每交付10 MW的数据中心容量,代工厂就必须额外构建1 MW测试能量,“这是我们从未要求过的投资规模。”这代表供应链必须同步升级,才能支撑AI扩展的速度。

Rabinovitsj指出,AI正以惊人的速度改写所有基础设施规则。“我们以为已经懂得如何扩展数据中心,但事实上,AI正让我们重新学习。”

未来数年内,液冷、光互联与开放标准化将是推动整个生态前进的三大关键,也可能催生全新的数据中心架构与技术模式。

(首图来源:Meta)