麻省理工学院(MIT)计算机科学与人工智能实验室(CSAIL)最近开发新系统,以视觉和人工智能教导软件机器人理解自身运动。此创新不依赖传统传感器或手动编程,而是用消费级相机让机器人观察自己的动作,自建模型理解几何形状和可控性。论文刊登于《自然》期刊。

团队表示,新系统可能大大扩展软件和生物启动机器人的应用范围,能没有GPS、模拟或传感器也能及时适应环境。CSAIL主任丹妮拉·鲁斯(Daniela Rus)表示,新技术名为“神经雅各比安场景”(Neural Jacobian Fields,NJF),软件机器人手能只用视觉观察学习抓取物体,无需传感器或预装AI模型。

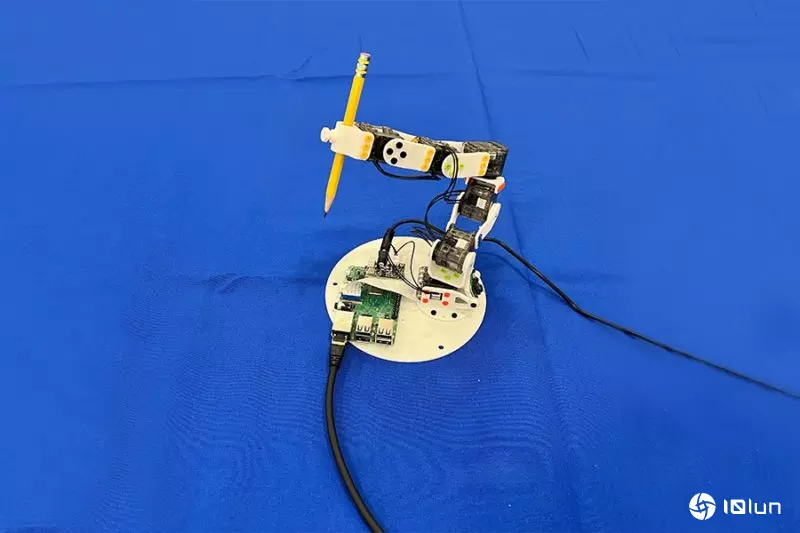

核心在机器人以相机观察自身运动并随机动作,创建自身运动的模型。研究员用计算机视觉和机器学习,以单一图像重建机器人3D模型,并以运动关注算法关注机器人训练时运动模式。三种机器人都能学到自身长相,并理解可执行动作。3D打印DIY玩具机器手臂学会以厘米级精确度空中写字;气动机器手臂观察自身运动,学会控制每根手指气流。

新研究不仅展示软件机器人如何用视觉获自我意识,还预言低成本制造、家庭自动化和农业机器人等行业的潜在应用。新方法消除专家创建准确模型的需求,并降低依赖昂贵传感器系统,以后可能会出现更多只靠视觉和触觉运行的经济型机器人。

(首图来源:MIT CSAIL)