本周Nvidia赶上Meta新版Llama 3.1模型列车,宣布可让企业在Nvidia云计算上定制化AI模型的解决方案AI Foundry。

Nvidia是在Meta宣布Llama家族模型3.1版,包括405B时公布这项方案。Meta Llama 3.1同步在包括Nvidia内25家云计算平台上线。

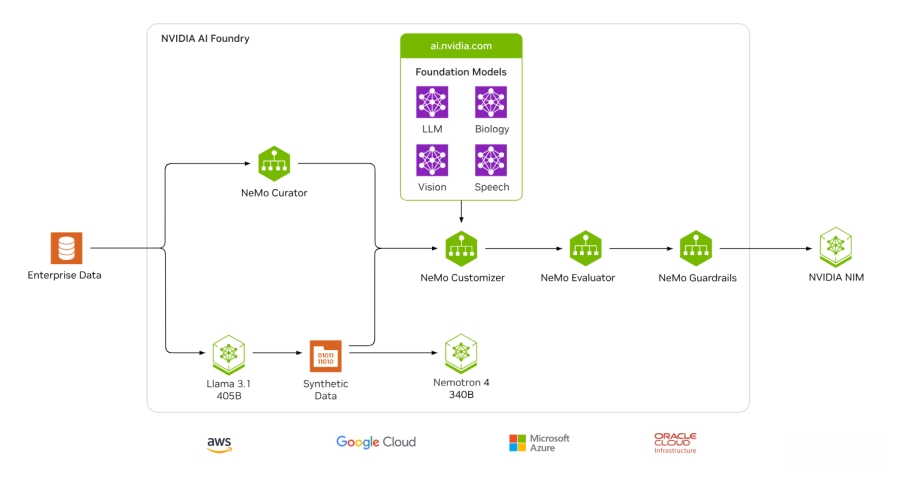

Nvidia说明,AI Foundry是一项AI服务,目的在让企业使用数据、高速计算资源和软件工具来开发部署自制模型,以增强其生成式AI项目。AI Foundry集成Nvidia云计算平台DGX Cloud、NVIDIA NeMo及第三方工具和支持,可搭配多种底层模型。AI Foundry提供企业定制化的模型,包括Nvidia Nemotron和开源模型,包括Meta开源的Llama 3.1与CodeLlama、Google DeepMind开源的CodeGemma和Gemma、Mistral AI的Mistral和Mixtral、微软Phi-3、StarCoder2等。

图片来源/Nvidia

企业客户可以将其在AI Foundry定制的模型,连同优化的引擎及标准API输出为Nvidia NIM推论微服务,执行在其属意的加速基础架构上。而推论方案如Nvidia TensorRT-LLM,可加速Llama 3.1模型执行,降低延迟性和扩大传输吞吐量,可让企业更快产生字符,减少从提示输入的成本。此外Nvidia AI Enterprise软件组件则提供安全性及管理、优化组件等底层支持。

客户可以使用Nvidia合作伙伴提供的AIOps和MLOps平台开发AI Foundry模型,包括Cleanlab、DataDog、Dataiku、Dataloop、New Relic、Scale等。AI Foundry全球服务技术伙伴包括Accenture、Deloitte、Infosys和Wipro等。

首先使用AI Foundry的客户包括SAP、Capital One、KT、现代汽车、Snowflake、图库企业Getty Images等。

最新服务是Nvidia从单纯基础架构企业迈向更全面的云计算平台的最新发展。Nvidia与Meta首席执行官黄仁勋和Mark Zuckerberg预定7月29日将在一场活动中对谈,说明生成式AI和开源软件如何帮助开发者及创作者,以及生成式AI在元宇宙中的角色。