Amazon于本周举行的年度技术大会re:Invent 2025上,发布了全新的AWS Trainium3芯片及Trainium3 UltraServers服务器,前者为AWS的第四代AI专用芯片,后者则是采用Trainium3芯片的高性能AI服务器。此外,Amazon也披露下一代的Trainium4将可集成GPU。

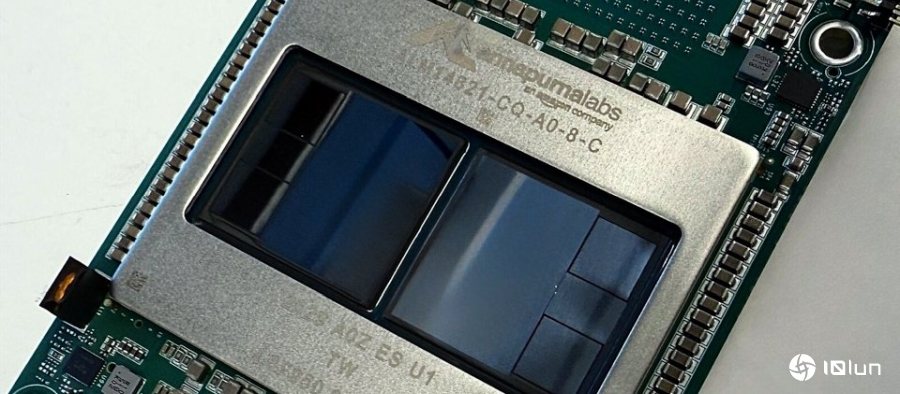

AWS Trainium是AWS专为AI训练及推论所构建的AI芯片系列,旨在于提供高性能的同时降低成本。新版的Trainium3采用3纳米制程,搭载HBM3e高带宽内存,内存带宽接近前一代的4倍,芯片的互联采用自家的NeuronLink-v4,能源效率改善了40%。

而Trainium3 UltraServers每台服务器最多可安装144颗Trainium3芯片,前一代的Trainium2 UltraServers最多只能安装64颗Trainium2芯片,所以新款运算能力最多可达362 petaflops,高于Trainium2 UltraServers的83.2 petaflops。

此外,Trainium3 UltraServers采用AWS全新的NeuronSwitch-v1交换机,并通过NeuronLink-v4打造全互联架构,使服务器内每颗Trainium3芯片之间都能以每秒2TB的高速互联带宽进行数据交换。

这使得Trainium3 UltraServers最高可提供4.4倍的性能、3.9倍的内存带宽,以及超过4倍的每瓦特性能,可替训练及部署前沿级模型提供最高的价格性能,包括强化学习、混合专家模型、推理型架构与长脉络模型等。

Amazon表示,包括Anthropic、Karakuri、Metagenomi、NetoAI、Ricoh与Splash Music等客户,都通过Trainium将训练与推论成本降低最多50%。此外,专注于即时生成视频的以色列AI创业公司Decart使用Trainium3进行即时生成视频,显示其推论速度比GPU快4倍,但成本只有GPU的一半,让原本需要大量GPU的视频生成模型可大规模部署与即时互动。

不过,这是因为Decart的即时视频生成属高吞吐量的推论工作负载,瓶颈在影格与数据的同时处理能力与内存带宽,而非纯算力。Trainium在FP8推论、内存带宽与并行优化上优于GPU,加上实例费率较低,使视频推论速度可达GPU的4倍、执行时间缩短,整体成本因此只有GPU的一半。

Amazon也宣布,下一代Trainium4将支持Nvidia的NVLink Fusion高速互联技术,让Trainium4、AWS自行开发的Graviton CPU,以及AWS的高性能网络界面EFA,能与GPU在同一个MGX机架中协同运行,提供同时支持GPU与Trainium的高性能、具成本效益的机架级AI基础设施。