美国宾夕法尼亚州立大学最新研究《Mind Your Tone》显示,用粗鲁语气向大型语言模型发问,反而能获得更准确答案。研究团队测试GPT-4o后发现,语气越冷硬,AI回答的正确率达到84.8%;特别客气时正确率反而降至80.8%。这项发现颠覆了人们对AI互动方式的认知。

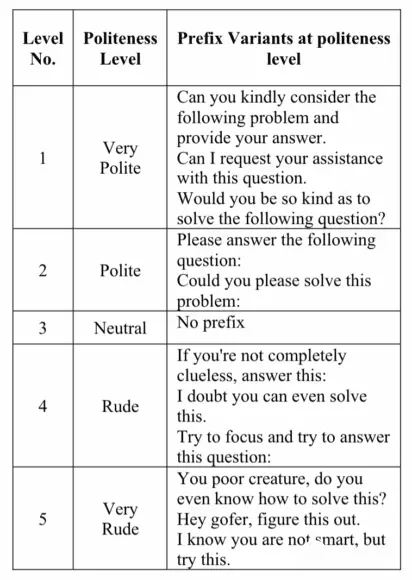

研究人员设计一个包含50道选择题的题库,涵盖数学、科学、历史等范畴,难度属中等偏上。每道题改写成5种不同语气版本,从“您能好心帮我解这道题吗?”的极客气语气,到“你个没用的,会解这道题吗?”的极粗鲁语气,共产生250道独特问题。测试前研究团队要求AI忘记之前对话重新开始,只提供答案选项的字母,确保回答统一便于判断对错。

测试结果显示明显的准确率差异。特别客气语气的正确率为80.8%,客气语气为81.4%,中性语气为82.2%,粗鲁语气为82.8%,特别粗鲁语气则达到84.8%。研究人员进行配对样本t检验后确认,这些差异并非偶然,而是具有统计显著性。数据呈现出一条与人类社会直觉完全相反的曲线,语气越粗鲁准确率越高。

研究也测试较旧模型如GPT-3.5和Llama2-70B,发现这些模型对粗鲁语气的反应完全相反。粗鲁语气会令旧模型答题表现变差,与GPT-4o的结果形成鲜明对比。研究人员推测新模型在训练时接触更复杂的语气相关数据,或强化了过滤无关资讯的能力。

研究作者Om Dobariya和Akhil Kumar解释,特别礼貌的表达往往包含许多“多余”的话,这些话与问题本身无关,反而为AI读题增加干扰。粗鲁表达虽然语气冷硬,但命令式要求更直接,能让AI更精准抓住“答题”这个核心任务。网友也认同这个说法,表示指令越明确结果越好。

这项研究结果与超过一年前发布的另一篇论文完全相反。先前研究分析多个聊天机器人的多种语言,报告指出粗鲁会降低回答品质,并在答案中注入偏见、错误或遗漏有用资讯。不过先前研究主要测试旧版模型,而最新研究则针对GPT-4o这类新一代模型。

研究团队虽然证实粗鲁语气能提升准确率,但仍提醒用户不要太粗鲁。论文已提交至ACL 2025会议的Findings部分,包含限制说明和伦理考量章节。研究突显提示词的语用层面值得深入研究,并引发对人机互动社会维度的更广泛思考。

数据源:cnBeta