内存大厂三星(SAMSUNG)在2025 OCP全球高峰会中发布了其革命性的CXL内存模块(CMM)路线图,并详细展示了针对下一代智能代理(Agentic AI)服务器平台设计的异质内存系统架构。

三星表示,此项发布的核心在于CMM-D系列的持续扩展,目的是通过CXL技术提升数据中心及AI工作的内存扩展性与效率,巩固三星在长期市场中的领导地位。

CMM-D迈向1TB容量与72GB/s带宽三星正在积极扩展其CMM路线图,特别是CMM-D系列,目标是在2025年推出CMM-D终极版本,以实现商业化目标。CMM-D产品系列是业界重要的CXL内存扩展解决方案,为数据中心和AI工作执行提供可扩展、高容量的内存。

三星指出,目前的阶段在CMM-D 1.1的部分,涵盖了业界首个CXL解决方案,并使用开源固件(Open-source firmware)。而CMM-D 2.0则是专注于构建学习平台和提供全方位解决方案。其中,CMM-D 2.0提供128GB或256GB的容量选择,且支持高达36GB/s的带宽。这些产品符合CXL 2.0标准,采用PCIe Gen 5 x8界面,并支持DDR4/DDR5双DQS信道。当前已经准备对客户样品。

至于,在CMM-D 3.1方面,三星的目标是通过CMM-D 3.1来实现长期的技术件展,包括预计在2025年达到设计导入,其容量可扩展至惊人的1TB,带宽将大幅提升至72GB/s,支持CXL 3.0,特别是针对更长电缆长度的收发器(Transceiver)技术。此外,界面升级至PCIe Gen 6 x8,并持续支持DDR5双DQS信道。而CMM-D 3.1的额外特色包括ITB、压缩(Compression)FMM引擎。而CMM-D 3.1首批样品即将推出。

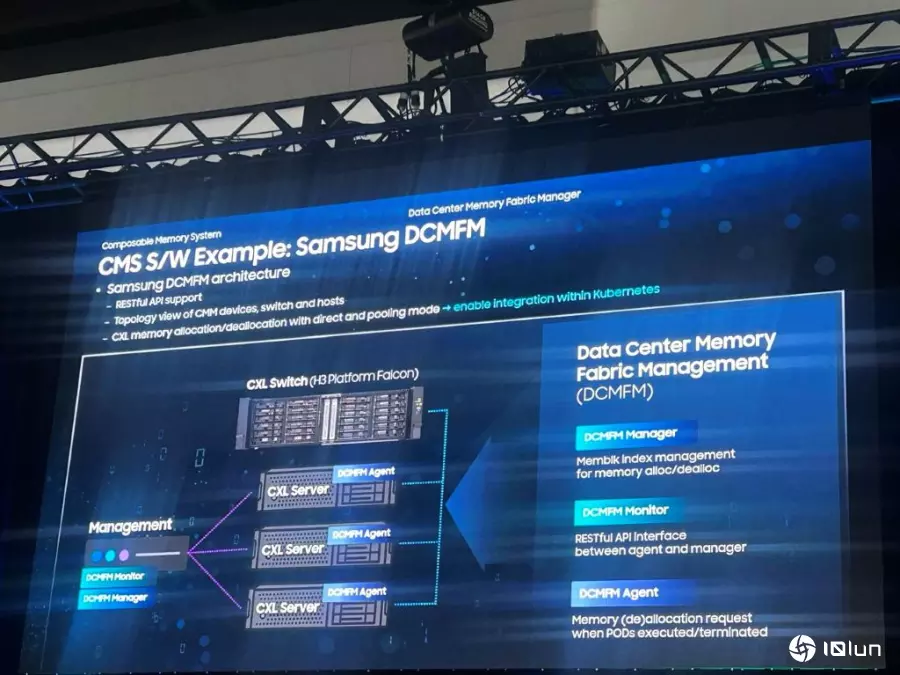

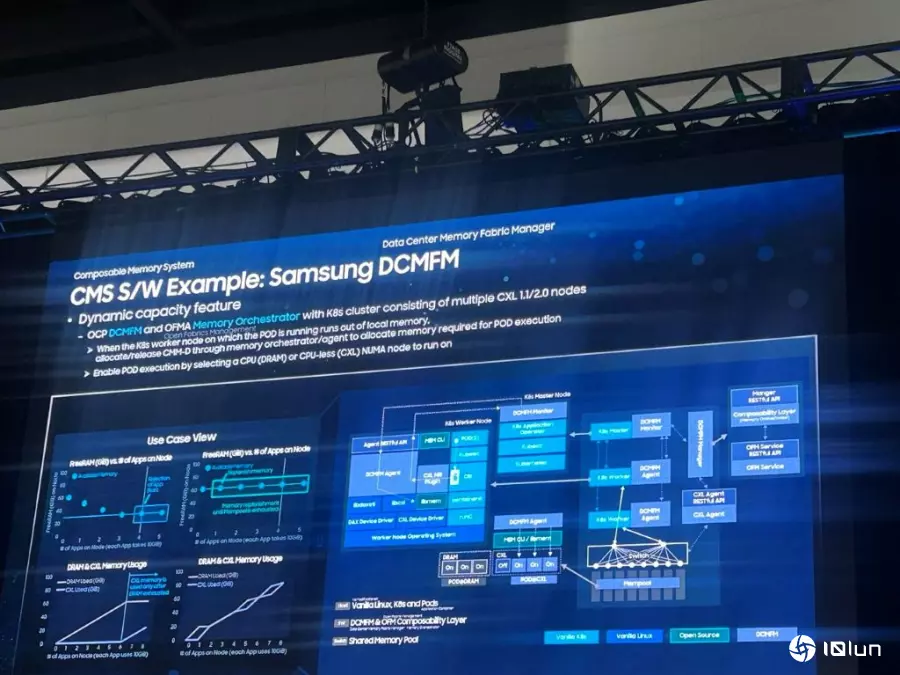

DCMFM实现软件定义内存的目标三星还强调借Data Center Memory Fabric Management (DCMFM) 实现软件定义内存的目标。三星表示,随着数据中心工作执行,特别是AI和Kubernetes应用方面的复杂性增加单纯依赖传统的内存配置方法已不足以应对。三星意识到,现有方法常过度依赖内存使用率预测,导致资源预测不准确、过度承诺,以及难以确切知道应用程序需要多少内存资源。

为了解决这些挑战,三星推出了数据中心内存光纤管理(DCMFM)系统,作为其CMS软件解决方案的范例。而其DCMFM架构的关键要素能提供集中的内存配置管理,用于内存的分配与解除分配,且系统由DCMFM Manager负责内存分配管理,而由DCMFM Agent负责处理来自Manager的内存分配请求所构成。DCMFM Monitor则用于观察已分配/已终止的内存请求。

借由以上的架构,三星强调,DCMFM能够与Kubernetes无缝集成,提供CXL设备、交换机和主机的拓扑视图,并支持资源解耦/重新分配,涵盖直接连接模式和池化模式。另外,通过CMS S/W(DCMFM),三星展示了动态内存调整大小的范例,以应对内存耗尽的问题。此解决方案的成果,就是可以在最新的Vanilla X86、Linux和CXL 2.0服务器CPU上运行。而且,还具有直接池化功能,通过VNNP到PPM的桥接技术在LD单元上完成。

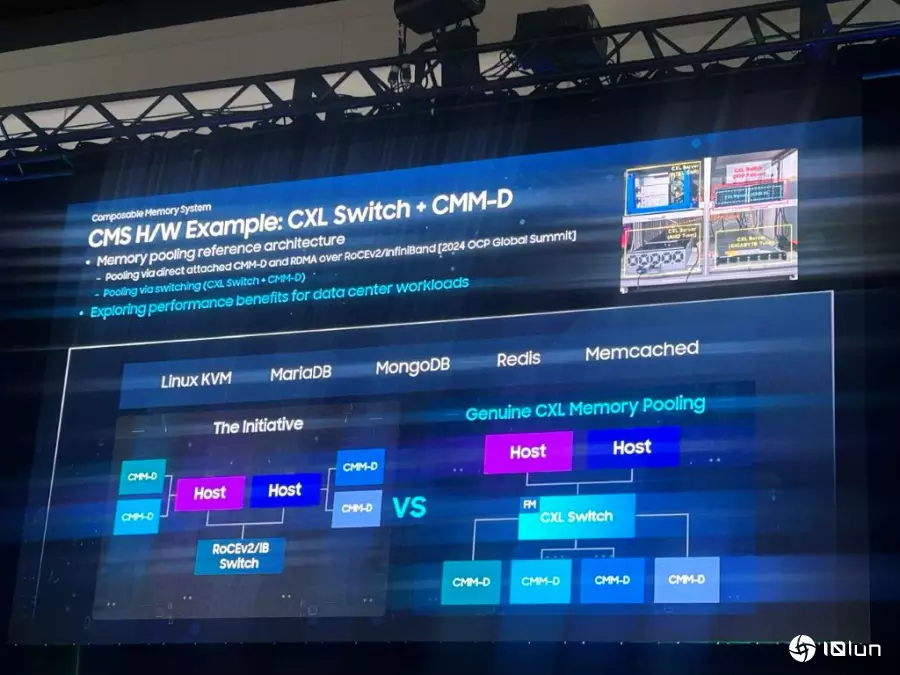

三星演示了结合CXL Switch和CMM-D的硬件架构参考设计。其中,在CXL内存池化的设置中,主机(Host)通过CXL Switch连接到多个CMM-D模块。这与传统方案(Host通过Rcvd/Tx Switch连接CMM-D)形成对比。

软件定义内存的需求迫切根据云计算服务数据显示,在2023年,AWS、Azure和Google Cloud中只有10%的预配CPU资源被利用。这突显了数据中心在资源分配上存在巨大的浪费,因为内存资源通常与CPU一并预配。通过CXL技术,远程访问(remote access)显著改善了内存利用率,并降低了相较于传统解决方案的延迟与开销。预计到2025年,预配CPU的使用率将从2023年的13%上升到23%。

总体而言,三星通过结合其高容量、高带宽的CMM-D硬件路线图与先进的DCMFM软件管理系统,为下一代AI服务器平台提供了一个全面的异质内存系统架构。这不仅解决了当前云计算资源利用率低下的问题,同时也为数据中心和AI工作负载带来了显著的性能提升和TCO优化。

(首图来源:三星)