OpenAI周四(10/30)发布了基于GPT-5的AI安全工具Aardvark,它能像人类安全专家一样分析程序代码、找出漏洞并自动提出修补方案。

Aardvark的核心设计是以LLM推理为基础,而非传统工具如fuzzing或软件组件分析。它能读懂整个程序库的架构、创建威胁模型,并以逐行理解的方式发现逻辑错误、未完整修补的历史问题与隐私相关漏洞。当存储库被连接后,Aardvark会先全面扫描历史,之后持续监控每一次提交,并在程序代码变动时即时侦测新漏洞。

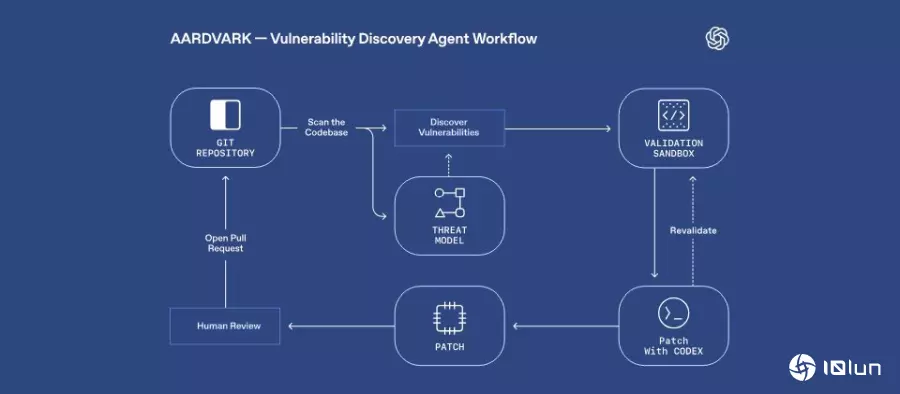

整个漏洞处理流程包含四大阶段:首先进行程序代码库的分析,创建威胁模型;其次,对每次提交进行比对与扫描;第三步在沙盒(Sandbox)环境中尝试实际触发漏洞,确认可利用性并降低误报;最后,Aardvark会通过Codex生成修补程序代码,并附上一键提交Pull Request的选项。OpenAI表示,这能让工程团队在不打断开发速度的情况下,快速采用高品质修补。

在基准测试中,Aardvark可找出92%的已知与人工加入漏洞,侦测率远高于多数传统工具。OpenAI表示,Aardvark已于该公司内部协助披露多个具实际影响力的安全问题,外部测试伙伴也发现Aardvark可找到只有在高度复杂条件下才会出现的安全漏洞。

OpenAI也将Aardvark应用于开源领域,迄今已于多个开源项目中找到并披露漏洞,其中有至少10个已取得CVE编号。未来OpenAI将提供部分非商业开源项目免费扫描。

OpenAI认为,现在所有的行业都靠软件运行,因此只要是软件有漏洞,就会造成产业与社会的风险,光是2024年就有超过4万个漏洞被公开,此外,其内部测试显示,约有1.2%的程序代码提交会自然引入新的bug,这也使得Aardvark被当作防御者优先模型,可于漏洞尚未被利用之前早期预警,并提供可行的修补方案。

Aardvark目前处于私人测试阶段,OpenAI正邀请特定合作伙伴参与测试,未来将逐步扩大使用范围。