NVIDIA在媒体说明会最新MLPerf训练测试成绩,GB200 NVL72不但能够完成所有测试项目,性能表现与成本效益也大大幅超越前代产品。

MLPerf是由学术界、研究实验室和业界人士共同组成组织旨在打造公正且能够反映实际应用场景的AI运算测试基准。先前NVIDIA已经发布GB200 NVL72在MLPerf推论测试的表现,这次则是发布训练测试的成绩。

MLPerf自2018年推出基准测试以来,这次已经是第12轮测试,NVIDIA推出的AI运算平台在每项测试皆有出色表现,且提交包含Llama 3.1 405B大型语言模型(Large Language Model,LLM)预训练在内的所有项目成绩,是唯一提交MLPerf Training v5.0基准测试所有项目测试结果的平台。

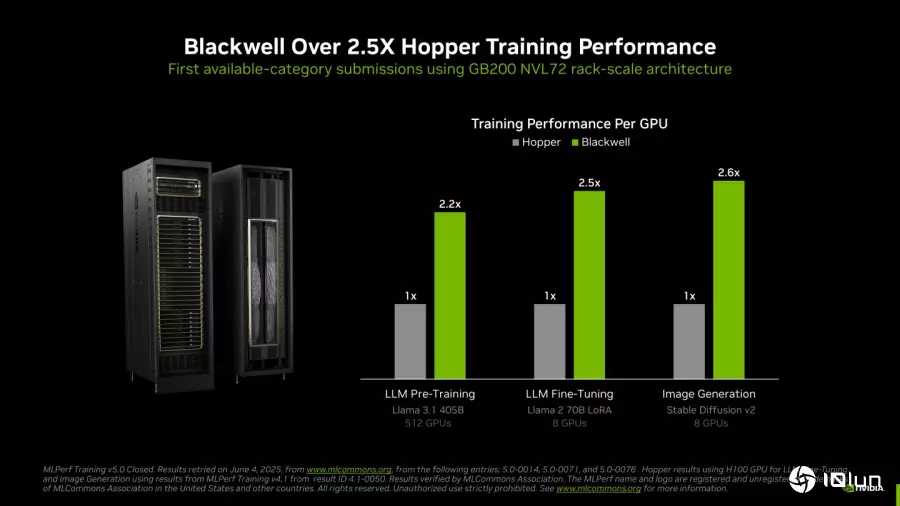

在全新的Llama 3.1 405B预训练测试中,Blackwell GPU的性能较前代架构在相同规模下提升了2.2倍。而在Llama 2 70B LoRA微调测试中,搭载8组Blackwell GPU的NVIDIA DGX B200系统性能较前代架构使用相同数量GPU的测试结果提升2.5倍。

NVIDIA在MLPerf Training v5.0训练测试中创下5项新纪录。

NVIDIA在MLPerf Training v5.0训练测试中创下5项新纪录。

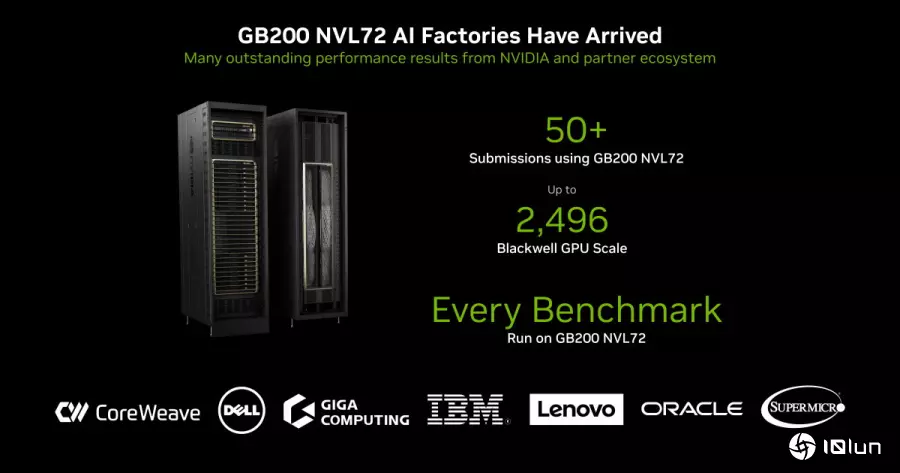

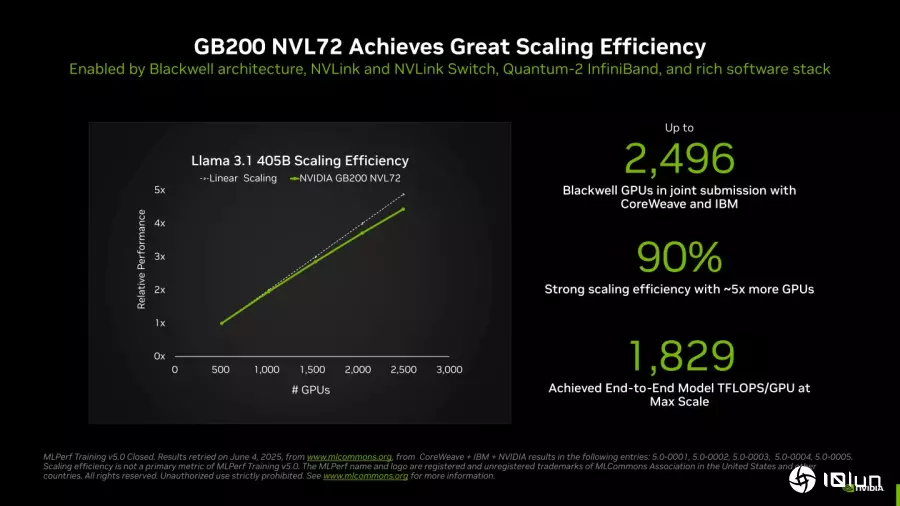

NVIDIA与合作伙伴提交超过50组GB200 NVL72测试成绩。NVIDIA与CoreWeave、IBM合作的部分使用提交使用2,496组Blackwell GPU和1,248组Grace CPU的成绩,展现其Scale-Out扩展能力。

NVIDIA与合作伙伴提交超过50组GB200 NVL72测试成绩。NVIDIA与CoreWeave、IBM合作的部分使用提交使用2,496组Blackwell GPU和1,248组Grace CPU的成绩,展现其Scale-Out扩展能力。

在相同数量GPU的条件下,Blackwell架构最高能领先前代Hopper架构达2.6倍。

在相同数量GPU的条件下,Blackwell架构最高能领先前代Hopper架构达2.6倍。

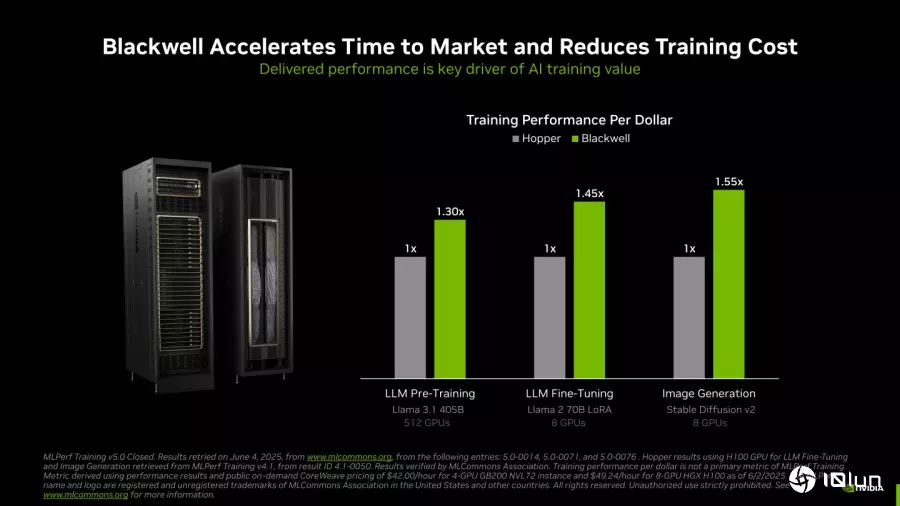

比较单位成本的训练性能,Blackwell架构也能达到Hopper架构的1.55倍。也就是说在相同花费下,Blackwell架构具有1.55倍的产出。

比较单位成本的训练性能,Blackwell架构也能达到Hopper架构的1.55倍。也就是说在相同花费下,Blackwell架构具有1.55倍的产出。

NVIDIA的强项在于集成NVLink、InfiniBand等总线与网络界面,让Scale-Out的效率可以达到90%,。

NVIDIA的强项在于集成NVLink、InfiniBand等总线与网络界面,让Scale-Out的效率可以达到90%,。

NVIDIA表示这些由代理型AI驱动的应用程序需要依赖AI工厂产生,而在数据中心电力供应有限的情况下,采用电力效率更高的AI运算单元代表着更高的产出,也将创造更高的产值。