看准移动设备端的AI应用潜力,Arm发布新的Lumex运算符系统(Compute Subsystem,CSS),一举更新旗下的行动CPU、GPU,搭配新的SME2(Scalable Matrix Extension 2)可扩延展伸指令集,宣称AI性能最高提升5倍。

Arm手机策略总监蔡武男表示,如今时代已习惯在智能手机屏幕触摸,但是未来AI在移动设备的普及,带来新的人机互动,未来新时代可能不再使用触摸,而是通过语音和手机对话,要求AI或是由AI依据你的需求执行任务。尽管移动设备可依赖云计算来执行AI推论,但是手机移动性难免处在移动网络不稳定的情形,没有移动网络或是信号较差的环境,将影响移动设备上的AI使用体验,此外,完全依赖云计算来执行AI推论,对服务提供商而言,成本也会高昂。

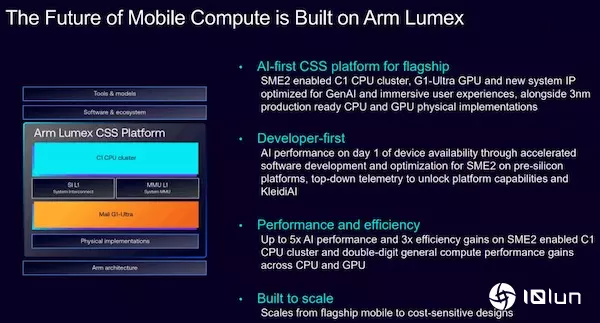

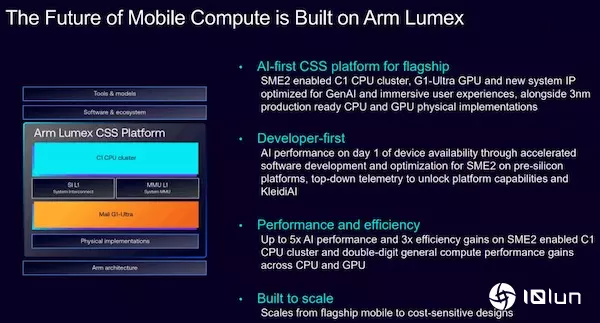

鉴于AI将会越来越重要,在移动设备端执行AI应用,即时性、低延迟特别重要,且因为手机使用电池,还需要更高的能源效率,Arm发布全新的Lumex CSS运算平台,搭载新的SME2指令集,这个新的矩阵延伸指令集,使得Lumex CSS提升CPU的AI处理性能最高达5倍,对于语音类的工作负载延迟可降低4.7倍,音频生成速度则提升2.8倍。(下图来源:Arm)

Arm以运动App“智能瑜伽教练”为例,在SME2指令集的加速下,文本转语音生成速度可提升2.4倍,用户可以更即时得到AI的瑜伽指导。

而根据Arm展示的AI加速效果,没有搭载SME2指令集的CPU,在达行神经网络的工作处理中,远低于GPU,但是搭载SME2指令集的CPU,明显提高神经网络的处理性能,缩短CPU与GPU间的性能落差,在一部分的测试项目中还超越GPU。

为吸引软件开发者,Arm也提供KleidiAI函数库,希望能让设备发挥SME2。目前KleidiAI支持AI框架,如PyTorch ExecuTorch、Google LiteRT、ONNX Runtime等。

Arm预期未来让SME2扩展到各个CPU平台,同时预期到了2030年,搭载SME与SME2的设备将会为超过30亿台设备添加加超过100亿TOPS。(下图来源:Arm)

更新CPU及GPU

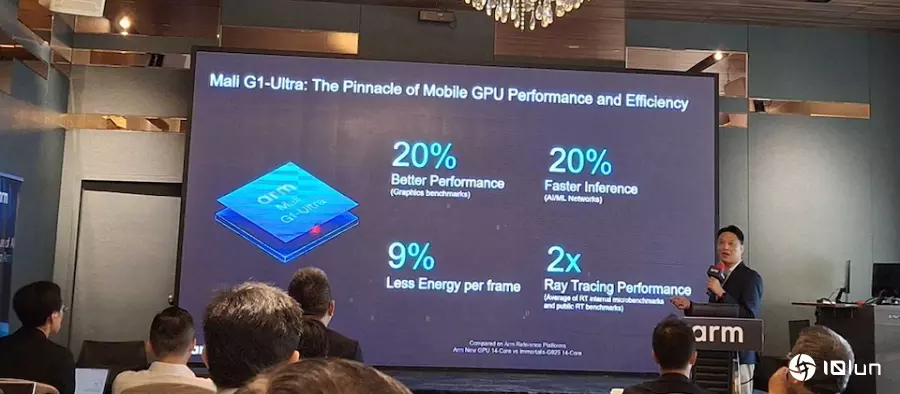

Lumex CSS目前针对3纳米制程优化实体实例,Lumex CSS包括采用SME2的Armv9.3 CPU集群,还有宣称提升2倍的光线关注性能的Arm Mali G1-Ultra GPU,以及DSU(Arm C1-DSU), KleidiAI函数库。

至于CPU方面,Lumex CSS更新Arm原有的行动CPU命名及分类方式,过去Arm CPU采用的Cortex命名,现在在Lumex中CPU采用C1命名,将CPU分为5个种类等级。

这5种类的CPU,包括Arm C1-Ultra,C1-Pro、C1-Premium、C1-Pro、C1-Nano、Pico。其中的C1-Ultra定位为旗舰级性能,相当于先前的Cortex-X925,在SME2加持下,Arm称其单线程性能提升25%,适用于大模型的推论、内容创作、生成式AI、运算摄影等等。

而C1-Pro为能耗核心,即扮演过去的小核角色,持续性能提升16%,在移动设备中用于辅助C1-Ultra性能核心(大核),C1-Pro适用于视频播放、流媒体推论等工作负载处理。

C1-Premium兼顾C1-Ultra的性能,但面积减少35%,适用于次一级的旗舰级移动设备,适合语音助理、多任务处理。

至于C1-Nano强调能效,Arm宣称其效率提升26%,但面积更小,因此适合行动穿戴设备或小型设备使用。最后是Pico,强调超低功耗,适用于物联网设备。

蔡武男指出,在今年5月Arm宣布转型后,将从过去只提供IP,转型为提供集成及弹性的平台方案,加速合作伙伴推出产品至市场的速度。

Arm针对不同市场提供运算平台方案,除了Lumex CSS运算平台锁定的移动设备外,还有以数据中心为目标的Arm Neoverse,瞄准汽车领域的Arm Zena,专门为PC设计的Arm Niva,以及适用于IoT物联网的Arm Orbis。