2022年AI热潮爆发后,NVIDIA一直是市场的领导厂商,但面对AMD的持续追赶,并积极扩展旗下产品线,NVIDIA面对局势将越来越艰困。

外媒WCCFtech分析AMD近期的策略,称NVIDIA之所以在AI市场取得优势,原因是它最早推出AI芯片解决方案。当时AMD和英特尔仍停留在传统CPU和GPU阶段,直到聊天机器人ChatGPT问世后,AMD才意识到AI发展已势不可挡,因此于2023年宣布将全面转向AI。

但在这个时期,NVIDIA已经以Ampere和Hopper架构抢占市场,并构建起强大的软件生态系,AMD如同在一场单方面压倒的市场中姗姗来迟。

而在2023年的AI热潮下,摆脱NVIDIA的掌控绝非易事,因为许多科技巨头签约、只能依赖其AI芯片,无法选择其他替代方案。同时,在CUDA等服务打造出的“护城河”生态系下,用户几乎无法转投AMD的怀抱。

黄仁勋成功创建起一个只能靠他们产品运行的市场,这导致AMD虽然推出Instinct MI300X等AI加速器,却始终难以获得大规模客户采用。

AMD不只竞争芯片表现,还有NVIDIA整个生态系AMD首款主要AI解决方案为Instinct MI300系列,号称可媲美NVIDIA H100,不仅内存容量是对方两倍、内存带宽也不相上下,更搭载性能大幅提升的CDNA 3架构。据内部测试显示,MI300X在AI推论应用上确实对H100造成威胁。

然而,AMD面对的不是单一对手,而是一整个NVIDIA创建的完整生态系。

由于对开发工具和AI框架的掌控,NVIDIA成为业界的首选平台,AMD则归类为“挑战者品牌”。要打造AI基础建设不只是单纯购买AI芯片,还必须考量整个软硬件系统,即使AMD提供更强大的硬件能力,转向AMD的整体成本仍高于沿用NVIDIA芯片。

针对NVIDIA的护城河生态,AMD选择拥抱开放路线。目前AMD推出开源AI软件平台“ROCm”,将用户从CUDA生态系中解放,提供高性能计算(HPC)和AI Instinct GPU的支持。除既有的Linux操作系统外,ROCm现全面支持Windows操作系统,能在AI PC和工作站等客户端设备上执行。另在AI网络技术部分,AMD同时通过UALink及UEC,满足“向上”(Scale-up+)及“向外”(Scale-out)扩展互联标准。

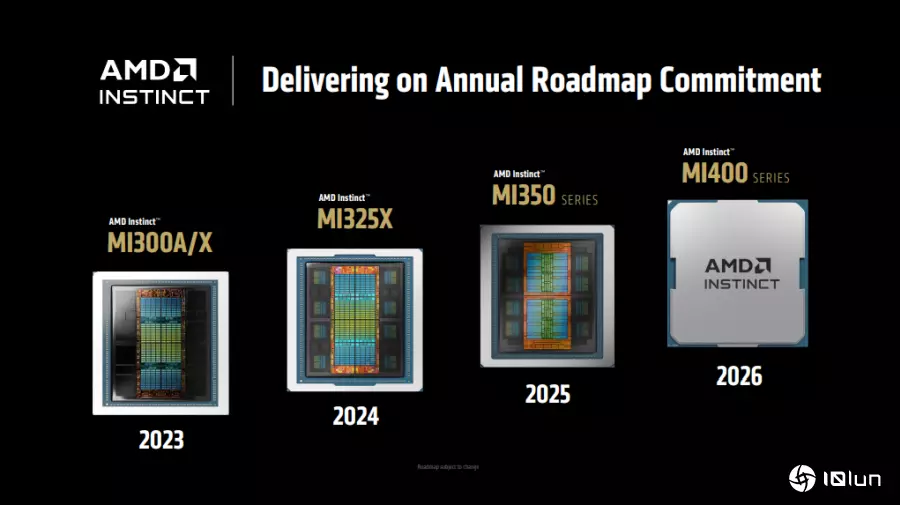

AMD拟推Instinct MI400、Helios解决方案应战此外,媒体的话语权也会塑造不同的产业氛围。该报道称,不少科技巨头会在新闻稿中提到使用NVIDIA设备,不只拉抬投资人信心,使NVIDIA占据市场主要话语权。如果OpenAI、微软改口语使用AMD的设备,可能遭外界解读“技术力下滑”等负面想法,导致AMD面临形象劣势。

不过,AMD推出有竞争力的产品后,以更具吸引力的价格、更高的供应能力,以及日益健全的生态系,积极向大型科技公司推销。据悉,其MI300系列比NVIDIA同类产品便宜20%-30%、性价比更好,逐渐获得微软和OpenAI等公司采用,但投资规模仍不及NVIDIA。

至于AMD下一代产品Instinct MI400系列,预期2026年推出,专为大规模训练和分布式推理设计。MI400搭载高达432GB HBM4内存,内存容量比现有方案提升50%,内存带宽达到19.6TB/s,同时将FP4精度下峰值算力翻倍提升至40 PFLOPS,FP8峰值性能达到20PFLOPS,每个GPU横向扩展带宽达到300GB/s,可实现跨机架和集群的高带宽互联。

此外,AMD同预期明年(2026年)推出AI机架式服务器架构“Helios”,这也是公司首个AI机架级解决方案,号称可对抗Rubin NVL72解决方案。

Helios集成AMD EPYC Venice CPU、MI400系列GPU和Pensando Vulcano NIC网卡及ROCm软件,支持紧密耦合的纵向扩展域,最多可容纳72个MI400系列GPU,纵向扩展带宽高达260TB/s,并支持Ultra Accelerator Link。

报道称,这些下一代产品都证明AMD在运算实力已准备与NVIDIA一较高下,但要打破垄断货场,单凭性能仍不够,还需创建能匹敌NVIDIA的完整软硬件生态体系。不过,市场也逐渐接受另一种观点,即AMD不一定要完全取代NVIDIA,而是与对手共存共荣。

(首图来源:AMD)